Warum LLMs keine AGI sind: Grenzen, Mythen und der nächste Schritt

Große Sprachmodelle wirken intelligent, doch ihnen fehlen Ziele, Grounding und verlässliches Schließen. Erörtert zentrale Grenzen, Mythen und realistische Wege nach vorn.

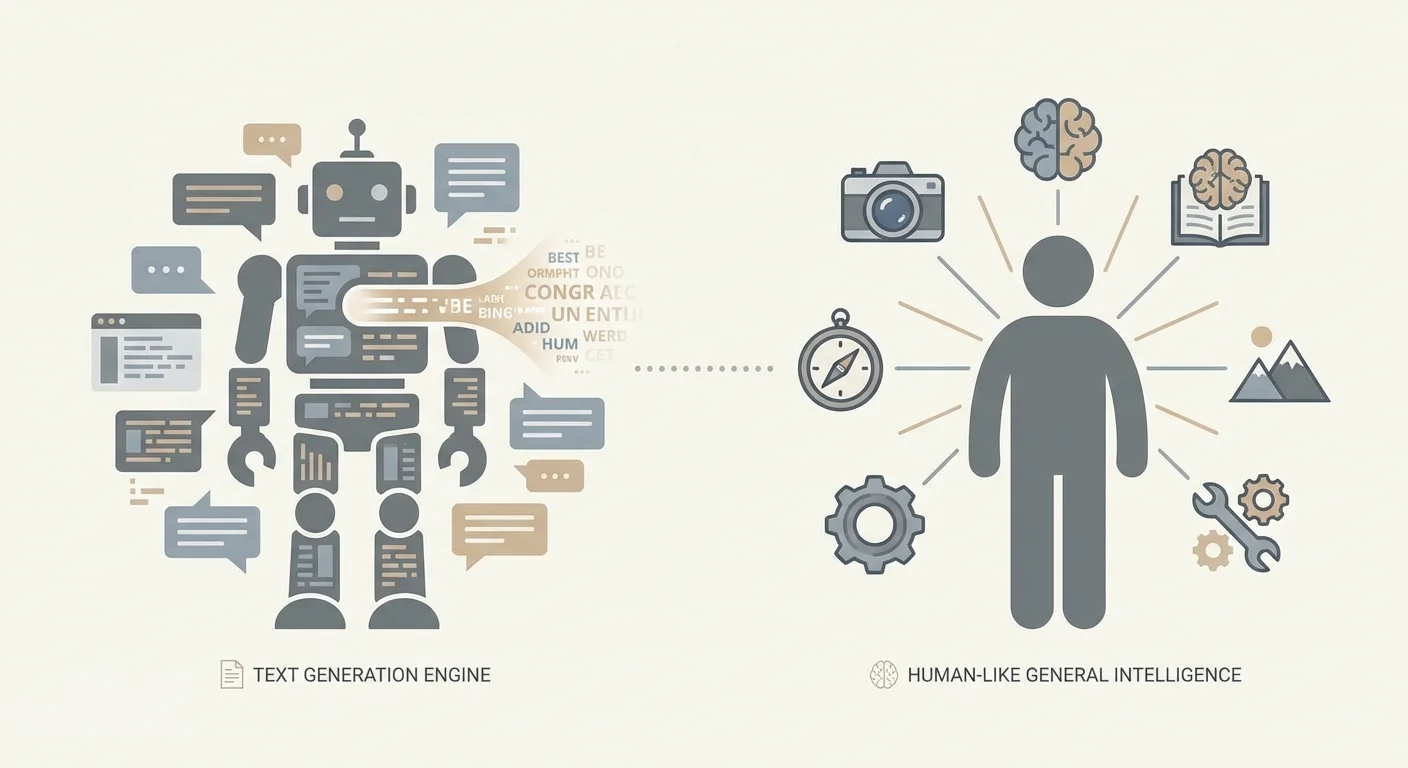

LLM vs. AGI: Was wir mit den Begriffen meinen

Ein großer Teil der Debatte „LLMs sind (oder sind nicht) AGI" ist eigentlich ein Terminologieproblem. Menschen verwenden dieselben Wörter mit unterschiedlichen Bedeutungen und reden aneinander vorbei. Bevor wir darüber streiten, was heutige Systeme leisten, hilft es, die Begriffe zu klären.

Ein LLM (Large Language Model) ist ein Modell, das darauf trainiert ist, Text (und manchmal andere Modalitäten) zu prognostizieren und zu erzeugen, basierend auf Mustern in großen Datensätzen. Es kann bemerkenswert fähig sein beim Erklären, Zusammenfassen, Übersetzen, Programmieren und Chatten — weil diese Aufgaben gut zu Textvorhersage passen. Diese Fähigkeit allein impliziert jedoch kein stabiles Weltverständnis, keine dauerhaften Ziele und nicht die Fähigkeit, unabhängig zu handeln.

Narrow AI beschreibt Systeme, die in spezifischen Domänen oder Aufgabenfamilien gut funktionieren — Spamfilter, medizinische Bildklassifizierer, Routenoptimierer und (argumentierbar) die meisten aktuellen LLM‑Einsätze. Solche schmalen Systeme können extrem mächtig und wirtschaftlich wichtig sein, ohne „general" zu sein.

AGI (Artificial General Intelligence) ist ein unschärferer Begriff; praktisch meint man üblicherweise einen Agenten, der in einer breiten Palette von Aufgaben und Umgebungen auf menschlichem Niveau (oder darüber) lernen und handeln kann, mit verlässlichem Schlussfolgern, Fähigkeitserwerb und der Kompetenz, über Zeit ohne konstante menschliche Stütze zu agieren.

Selbst „Generalisierung" kann verschiedene Dinge bedeuten. Manchmal heißt es: neue Formulierungen vertrauter Aufgaben bewältigen; manchmal: Fähigkeiten domänenübergreifend transferieren; manchmal: sich mit minimaler Anleitung an wirklich neue Situationen anpassen. Das ist nicht dasselbe. LLMs können im ersten Bereich glänzen und dennoch im letzten stark schwächeln.

Diese Debatte ist wichtig, weil reale Entscheidungen davon abhängen. Unternehmen könnten kritische Abläufe überautomatisieren, Regulierungen könnten fehlgeleitet sein, und Teams könnten in Sicherheitskontrollen unterinvestieren. In risikoreichen Bereichen — z. B. Softwareentwicklung oder Gesundheitssystem‑Workflows (einschließlich EMR/EHR‑Kontexten) — kann die selbstbewusste Ausgabe eines LLM wie Kompetenz wirken, bis ein Randfall auftaucht, bei dem Korrektheit und Nachvollziehbarkeit unabdingbar sind.

Dieser Artikel behauptet nicht, dass LLMs nutzlos oder „nur Autovervollständigung" sind. Er stellt fest, dass Sprachgewandtheit nicht gleich allgemeiner Intelligenz ist und dass heutige LLMs strukturelle Grenzen haben, die sie von AGI trennen.

„Nie" ist eine starke Behauptung. Betrachte sie hier nicht als Prophezeiung, sondern als Prompt: Was müsste sich architektonisch und auf Systemebene ändern, damit ein LLM‑basiertes Vorgehen in irgendeinem sinnvollen Sinne als AGI gilt?

Wie LLMs funktionieren (ohne Hype)

Große Sprachmodelle sind im Kern extrem fähige Textprädiktoren. Sie werden auf riesigen Textsammlungen trainiert und lernen statistische Regelmäßigkeiten: welche Wortsequenzen typischerweise folgen, wie Ideen ausgedrückt werden und welche Stile zu welchen Kontexten passen. Wenn Sie ein LLM prompten, „schlägt" es nicht eine gespeicherte Antwort nach oder konsultiert ein Weltmodell, wie viele sich das vorstellen. Es generiert das nächste Token, das am plausibelsten zu den bisherigen Tokens passt, und wiederholt diesen Schritt.

Training: Muster lernen, nicht garantiert Fakten

Während des Trainings sieht das Modell eine Tokenfolge und soll das nächste vorhersagen. Über viele Beispiele passt es interne Parameter an, so dass Vorhersagen besser werden. Das erzeugt eine beeindruckende Fähigkeit, Text kohärent fortzusetzen — weil Kohärenz stark mit den im Training gefundenen Mustern korreliert.

Mehr Daten und mehr Rechenleistung verbessern oft Flüssigkeit und Vielseitigkeit, weil das Modell mehr Muster repräsentieren und genauer anpassen kann. Mit ausreichender Kapazität handhabt es seltenere Konstruktionen, folgt längeren Kontexten und imitiert spezialisierte Schreibstile. Das garantiert jedoch kein stabiles, geerdetes Verständnis dessen, was es sagt; es bedeutet, das Modell ist sehr gut im Pattern‑Completion.

„Emergente" Fähigkeiten: überraschend, aber kein Zauber

Manche Fähigkeiten erscheinen bei größeren Modellen „plötzlich" — mehrstufige Erklärungen, grundlegende Programmierhilfe oder konsistenteres Befolgen von Anweisungen. Häufig ist das weniger mysteriös: Das Modell kombiniert vertraute Muster neu, transferiert eine über viele Beispiele gelernte Fähigkeit oder wird so zuverlässig, dass Nutzer die Änderung bemerken.

Solche Sprünge können dramatisch wirken, bleiben aber konsistent mit Next‑Token‑Prediction als zugrundeliegendem Ziel.

Warum Konversation in die Irre führen kann

Gesprächs‑Interfaces begünstigen eine menschliche Interpretation: Selbstbewusstsein klingt wie Wissen; ein hilfreicher Ton klingt wie Absicht; eine gut strukturierte Erklärung wie echtes Denken. Gesprächsfähigkeit ist jedoch nicht dasselbe wie Verständnis, Zielsetzung oder Wahrheitsverfolgung. In praktischen Einsätzen ist die sicherste Haltung, LLM‑Ausgaben als starken Entwurf zu behandeln — nicht als Autorität.

Text ist nicht die Welt: Die Grounding‑Lücke

Ein Sprachmodell kann überzeugende Beschreibungen der Realität liefern, ohne je in der Realität gewesen zu sein. Text ist Aufzeichnung menschlicher Erfahrung — Zusammenfassungen, Geschichten, Anleitungen, Argumente — nicht die Erfahrung selbst. Wenn ein LLM das nächste Wort vorhersagt, kann es so klingen, als „verstehe" es, aber es setzt möglicherweise nur Muster zusammen, die mit Verständnis korrelieren, statt die kausale, wahrnehmende Auffassung zu besitzen, mit der Menschen die Welt navigieren.

Was „Grounding" bedeutet

Grounding ist die Verbindung zwischen Symbolen (Wörtern, Zahlen, Labels) und etwas außerhalb der Symbole: Wahrnehmung, Handlung und Feedback. Menschen lernen, was „heiß" heißt, indem sie eine warme Tasse anfassen, zurückzucken und sich daran erinnern. Wir verfeinern „schwer" durch Heben, Scheitern, Griff anpassen und erneut versuchen. Diese Schleife — wahrnehmen, handeln, Konsequenzen beobachten — verankert Konzepte in der Realität.

Ein reines Textmodell fehlt diese Schleife. Es kann aufsagen, dass „Glas beim Fallen bricht", aber es besitzt diese Erwartung nicht so, dass sie sich aktualisiert, wenn sich Bedingungen ändern (dickes Glas, Gummiboden, geringe Höhe). Meist hat es keinen direkten Kanal, um zu überprüfen, was gerade wahr ist, in dieser Situation, unter diesen Randbedingungen.

Wo „Wissen über Dinge" versagt

Reine Sprachmuster sind in mehreren Situationen ein schlechter Ersatz für geerdete Interaktion. Physikalische Kausalität verlangt oft das Abwägen mehrerer wechselwirkender Faktoren statt das Erkennen eines Schlüsselworts. Räumliches Denken fällt bei Drehungen, konsistenten 3D‑Beziehungen oder dem Abbilden von Worten auf eine spezifische Umgebung leicht aus. Echtzeitkontexte — Lagerbestände, Sensorwerte, Patientenstatus — sind besonders riskant, weil eine „typische" Antwort veraltet oder gefährlich sein kann. Und wirklich neue Situationen legen die Kernbegrenzung offen: Raten, was plausibel klingt, ist nicht dasselbe wie Recht haben.

Warum diese Lücke zentral für AGI ist

AGI würde flexible Kompetenz über Umgebungen hinweg bedeuten, nicht nur eloquentes Kommentieren. Ohne Grounding kann ein LLM ein mächtiger Assistent sein, bleibt aber anfällig für selbstbewusste Fehler, wenn die Welt Verifikation, Experimentieren oder kalibrierte Unsicherheit verlangt.

Deshalb koppeln viele praktische Systeme LLMs mit Werkzeugen: Datenbanken, Sensoren, Simulatoren und menschlichen Prüfungen. In der angewandten Arbeit — besonders im Gesundheitswesen oder sicherheitskritischen Unternehmenssystemen — ist Grounding keine philosophische Frage; es ist der Unterschied zwischen einem hilfreichen Entwurf und einer verlässlichen Ausgabe.

Zuverlässigkeit: Halluzinationen, Fragilität und Wahrheit

LLMs können selbstbewusst klingen, auch wenn sie falsch liegen. Diese Fehler werden oft „Halluzinationen" genannt: Ausgaben, die flüssig, detailreich und bestimmt formuliert sind — aber nicht auf verifizierten Fakten beruhen. Das Schwierige ist, dass der Ton oft nicht von einer korrekten Antwort zu unterscheiden ist, sodass ein flüchtiger Blick eine schwache Strategie zur Validierung ist.

Warum flüssiger Text von der Wahrheit abdriften kann

Ein LLM optimiert die wahrscheinlichste nächste Tokenfolge gegebenen den Kontext. Dieses Ziel belohnt Plausibilität — was in ähnlichem Text typischerweise folgt — mehr als Wahrheitssuche. Fehlen die nötigen Informationen, liefert das Modell womöglich eine Schätzung, die dem Muster einer Antwort entspricht. Selbst wenn die richtige Information irgendwo im Trainingsdatensatz vorhanden ist, ruft das Modell sie nicht wie eine Datenbank ab; es sampelt aus einer gelernten Wahrscheinlichkeitsverteilung. Daher können Korrektheit und das Trainingsziel des Modells in Konflikt geraten.

Fragilität durch kleine Änderungen

Zuverlässigkeit bricht auch subtiler zusammen. Kleine Prompt‑Änderungen — Wortwahl, Reihenfolge, zusätzliche Einschränkungen — können deutlich unterschiedliche Ergebnisse liefern. Versteckte Einschränkungen, etwa langer Chatverlauf oder mehrdeutige Anforderungen, lenken die Ausgabe, ohne dass der Nutzer es bemerkt. Diese Brüchigkeit zeigt: Man interagiert mit einem sensitiven Generator, dessen Verhalten stark vom Kontext abhängt.

Entscheidungsunterstützung vs. Entscheidungsfindung

Aufgrund von Halluzinationen und Prompt‑Fragilität sind LLMs am besten als Entscheidungsunterstützung: Entwürfe erstellen, zusammenfassen, brainstormen, Domänensprache übersetzen und Optionen vorschlagen. Sobald man ihnen erlaubt, Entscheidungen zu treffen — eine medizinische Workflow‑Änderung zu genehmigen, eine Compliance‑Erklärung zu unterschreiben oder finanzielle Logik zu finalisieren — übernimmt man einen Fehlermodus, der subtil und überzeugend sein kann.

In Produktionsumgebungen reduzieren Teams dieses Risiko, indem sie Antworten in vertrauenswürdige Quellen einbetten oder strukturierte Daten nutzen, Belegabschnitte innerhalb des Workflows fordern (nicht nur selbstbewusste Behauptungen), kritische Schritte durch deterministische Validierung absichern (Schemata, Regeln, Unit‑Tests) und Human‑in‑the‑Loop‑Kontrollen für hochrelevante Aktionen behalten.

Zuverlässigkeit heißt nicht, Modelle „klüger klingen" zu lassen. Es heißt, Systeme so zu entwerfen, dass richtig klingende Ausgaben nie ausreichend sind.

Schlussfolgern ist nicht durch Flüssigkeit garantiert

Eine hartnäckige Fehlannahme lautet: Wenn ein Modell so reden kann, als würde es schlussfolgern, dann schlussfolgert es auch wirklich. LLMs generieren das nächste Token, das am besten zu Trainingsmustern und unmittelbarem Kontext passt. Dieser Prozess kann ein schrittweises logisches Auftreten imitieren — manchmal beeindruckend — ohne verlässlich die Eigenschaften echten Schlussfolgerns zu gewährleisten: Konsistenz, Vollständigkeit und Fehlerprüfung.

Wo LLM‑„Schlussfolgern" echt wirkt

LLMs liefern oft gute Ergebnisse, wenn richtige Antworten stark mit vertrauten sprachlichen Mustern korrelieren: Erklärungen entwerfen, Vor‑ und Nachteile zusammenfassen, plausible Lösungen vorschlagen oder Code produzieren, der üblichen Implementierungen ähnelt. Selbst ohne echte Beweise kann das Modell als heuristische Hilfe dienen: Es schlägt Ansätze vor, die ein Mensch validieren kann.

Wo Flüssigkeit versagt

Probleme treten auf, wenn eine Aufgabe strikte, langfristige Korrektheit erfordert statt einer plausiblen Narration. Mehrstufige Logik kann zusammenbrechen, wenn ein früher Fehler alles kontaminiert. Beweisartige Probleme brauchen lückenlose Beschränkungen, nicht überzeugende Prosa. Randfälle und seltene Bedingungen sind im Training oft unterrepräsentiert. Konflikte zwischen Anweisungen, Annahmen und versteckten Abhängigkeiten können die Completion inkonsistent machen. Und „antwortförmige" Ausgaben überspringen oft genau die Verifikation, weil sie gut lesbar sind.

Warum Tools und Verifikationsschichten wichtig sind

Die Lage ändert sich, wenn das LLM Teil eines Systems ist, das sich selbst prüfen kann. Externe Werkzeuge (Taschenrechner, Interpreter, formale Solver), Abruf autoritativer Daten und strukturierte Verifikation (Unit‑Tests, Konsistenzchecks, Cross‑Model‑Kritik, Human‑in‑the‑Loop) können flüssige Vorschläge in vertrauenswürdige Ergebnisse verwandeln.

Das macht das Basismodell nicht zur AGI. Es macht es zu einer mächtigen Schnittstelle zur Generierung von Kandidaten — während der Rest des Systems die Arbeit des Groundings und der Korrektheit übernimmt.

Agency und Ziele: Fehlende Zutaten

Wenn Menschen sich AGI vorstellen, denken sie meist an etwas mit Agency: es kann Ziele bilden, über die Zeit an ihnen festhalten, Aktionen planen, beobachten, was geschah, und sich anhand von Feedback anpassen. Agency ist nicht nur „Aufgaben erledigen." Es ist persistentes, selbstgesteuertes Verhalten in sich ändernden Situationen.

Die meisten LLMs haben das per Default nicht. Ein Chat‑Modell generiert das nächste Token gegeben den Prompt. Es kann eindrucksvoll über Ziele, Pläne und Absichten sprechen, aber es will intrinsisch nichts, und es verfolgt keine Ziele, wenn das Gespräch endet. Ohne eine externe Schleife hat es kein stabiles Ziel, kein fortlaufendes Feedback aus der Welt und keinen Mechanismus, selbstständig zu entscheiden, was als Nächstes zu tun ist außer zu antworten.

Chat‑Completion vs. agentische Systeme

Eine Chat‑Completion‑Architektur ist reaktiv: Du fragst, es antwortet. Eine agentische Architektur umgibt das Modell mit Gerüsten, die Persistenz und Kontrolle bieten — Task‑Queues, Tools (APIs), Memoriespeicher, Planer und Evaluatoren, die Ergebnisse prüfen. In diesem Setup zeigt das System agentenähnliches Verhalten; das Sprachmodell ist eine Komponente.

Diese Unterscheidung ist praxisrelevant. Wenn ein „AI‑Assistent" Jobs plant, Datensätze ändert oder Deployments auslöst, ist nicht die Schreibfähigkeit des Modells das gefährlichste — es sind die Berechtigungen und die Entscheidungsschleife drumherum.

Warum hinzugefügte Agency die Einsätze erhöht

Werkzeugzugriff und Autonomie können normale Fehlermodi verstärken. Das System kann das falsche Ziel verfolgen, vage Anweisungen überinterpretieren oder auf falsche Annahmen handeln. Die Lösung ist nicht allein ein „klügeres Modell"; es braucht Schutzmechanismen: klare Zielvorgaben, eingeschränkten Toolzugriff, Genehmigungen für weitreichende Aktionen, Monitoring und strikte Evaluation an realen Ergebnissen.

Gedächtnis, Identität und Kontinuität über die Zeit

LLMs können innerhalb eines einzelnen Gesprächs konsistent klingen, aber diese „Kontinuität" ist oft eine Illusion, erzeugt vom kurzzeitigen Kontextfenster. Innerhalb dieses Fensters kann das Modell Referenzen auf bereits Gesagtes halten und einen kohärenten Ton wahren. Darüber hinaus — über längere Sitzungen, Tage oder reale Aufgaben hinweg — besitzt es kein inhärentes dauerhaftes Selbst, keine stabilen Überzeugungen und kein anhaltendes Verständnis Ihrer Ziele.

Kurzzeitkontext ist kein Langzeitgedächtnis

Was Menschen als „Gedächtnis" beim LLM bezeichnen, ist meistens nur Text, der noch im Prompt sichtbar ist. Es ist eher Arbeitsgedächtnis als Lebensprotokoll. Fallen frühere Details aus dem Kontextfenster, erinnert sich das Modell nicht; es rät, was plausibel wäre.

Allgemeine Intelligenz, wie man sie sich üblicherweise vorstellt, hängt von Kontinuität ab: aus Fehlern lernen, verlässliche Fakten akkumulieren, Überzeugungen revidieren und langfristige Ziele beibehalten, auch wenn die Unterhaltung neu startet.

Identität und Präferenz‑Drift

Ohne persistente Zustände können LLMs sich über Sessions hinweg widersprechen: Ein Tool, das heute eine Methode „bevorzugt", empfiehlt morgen das Gegenteil — nicht weil es seine Weltanschauung aktualisiert hat, sondern weil es eine andere Completion sampelt. Selbst innerhalb derselben Sitzung können kleine Prompt‑Änderungen Prioritäten verschieben oder die Interpretation dessen, was der Nutzer meinte, erneuern.

Diese Fragilität ist relevant für reale Aufgaben — Anforderungsaufnahme, medizinische Dokumentation, mehrwöchige Softwareprojekte — in denen Konsistenz und Nachvollziehbarkeit genauso wichtig sind wie Sprachgewandtheit.

Gedächtnis per Retrieval und strukturierter Zustände (und was das nicht löst)

Teams ergänzen deshalb oft externes Gedächtnis: Retrieval‑Systeme, Datenbanken, Benutzerprofile und strukturierte Zustände, die wieder in den Prompt injiziert werden. Das verbessert Kontinuität deutlich und ist in Produktionssystemen üblich.

Übliche Ebenen sind Gesprächszusammenfassungen, Retrieval aus Dokumenten oder Wissensdatenbanken, Benutzerpräferenzprofile und Berechtigungen sowie strukturierter Task‑State (getroffene Entscheidungen, offene Fragen, Constraints). Das sind jedoch Gerüste um das Modell, kein intern selbstpflegendes Identitätsmodell. Retrieval kann den falschen Fakt liefern, Zusammenfassungen können Nuancen verlieren, und das Modell kann gespeicherten Zustand falsch interpretieren.

In der Praxis erfordert verlässliches Langzeitverhalten sorgfältiges Systemdesign plus Human‑in‑the‑Loop‑Kontrollen.

Generalisierung über die Trainingsverteilung hinaus

Falls AGI jemals existiert, müsste sie mehr tun als in vertrauten Mustern gut zu performen. Sie müsste Gelerntes in wirklich neue Domänen, Regeln und Ziele übertragen können — besonders wenn die richtige Antwort nicht durch das Remix von bereits Gesehenem zu finden ist.

Generalisierung vs. „scheint ähnlich genug"

Viel vom LLM‑Erfolg lässt sich besser als mächtige Interpolation beschreiben: Ausgaben produzieren, die mit der statistischen Struktur der aufgesogenen Daten konsistent sind. Wenn eine Aufgabe vertrauten Trainingsformaten ähnelt — Erklärungen, Zusammenfassungen, Code‑Patterns, Support‑Skripte — können LLMs breit fähig wirken.

Interpolation ist aber nicht Generalisierung im AGI‑Sinn. Ein Modell kann exzellent im Pattern‑Completion sein und dennoch scheitern, wenn eine Aufgabe das Lernen einer neuen Regel on the fly verlangt, das Aufbauen eines stabilen internen Modells einer unbekannten Umgebung oder die Revision von Überzeugungen bei widersprechenden Beobachtungen.

Aus‑der‑Verteilung‑Fehler sind keine Randfälle

Im echten Arbeitsleben entstehen ständig Out‑of‑Distribution‑Situationen: neue Regulierungen, neue Produktanforderungen, unerwartetes Nutzerverhalten, sich ändernde Tool‑Schnittstellen, Datensätze mit neuen Schemata. LLMs verschlechtern sich oft deutlich, wenn die Oberflächenform sich ändert oder wenn Erfolg von versteckten Constraints abhängt statt von textueller Plausibilität.

Probleme zeigen sich, wenn neue Regeln gängigen Konventionen widersprechen, wenn Aktionen mehr zählen als Formulierungen (mehrstufige Tool‑Nutzung unter Constraints), wenn seltene Konzeptkombinationen auftreten oder wenn Anweisungen adversarial oder mehrdeutig sind — Bedingungen, bei denen „richtig klingend" leicht, richtig zu sein aber schwer ist.

Warum Benchmarks Fähigkeiten beschönigen können

Benchmarks sind nützlich, aber oft auf Vergleichbarkeit optimiert, nicht auf Überraschung. Sobald ein Benchmark populär wird, prägt er Training, Prompting‑Strategien und Evaluationsnormen. Scores steigen, während die echte Frage — „Wird es das Nächste behandeln, das wir nicht getestet haben?" — offen bleibt.

Für Unternehmen ist diese Lücke operativ: Ein System kann auf Demos „AGI‑ähnlich" wirken und dennoch versagen, wenn ein Kundenworkflow vom Testset abweicht. Produktionssysteme brauchen in der Regel eingeschränkte Schnittstellen, Verifikationsschritte und menschliche Eskalation für wirklich neue Fälle.

Alignment und Sicherheit: Fähigkeit allein reicht nicht

Wenn Leute argumentieren, ein sehr fähiges Modell sei „praktisch AGI", konzentrieren sie sich meist auf Demos dessen, was es kann. Alignment stellt eine andere Frage: Verfolgt das System zuverlässig die Absicht des Nutzers innerhalb menschlicher Grenzen, selbst wenn der Prompt unklar, adversarial oder moralisch belastet ist?

In der Praxis bedeutet Alignment, Ziele (was der Nutzer will), Werte (was die Gesellschaft erlaubt) und Grenzen (Privatsphäre, Legalität, Sicherheits‑Policies, Betriebsregeln) in unordentlichen Situationen in Einklang zu bringen.

Warum RLHF hilft — und warum es nicht ausreicht

Instruction‑Tuning und RLHF (Training mit menschlichem Feedback) machen ein Modell kooperativer und weniger toxisch. Aber sie verwandeln das Modell nicht in einen konsequent prinzipientreuen Schlußfolgerer. Das System lernt weiterhin Muster bevorzugter Antworten, nicht ein tiefes Verständnis menschlicher Werte.

Alignment ist außerdem kein einzelnes Ziel. Man balanciert Ideale, die konfligieren können: Hilfsbereitschaft, Ehrlichkeit, Sicherheit, Privatsphäre und Fairness. Das Optimieren von einem drückt oft die anderen. Ein auf maximale „Hilfsbereitschaft" getrimmtes Modell kann zu viel spekulieren; ein streng auf Sicherheit getuntes Modell kann harmlose Anfragen ablehnen; ein übervorsichtiges Modell frustriert Nutzer und treibt sie in unsichere Workarounds.

Warum AGI‑Behauptungen Governance beinhalten müssen

Wenn „AGI" ein System meint, das breit und kompetent handeln kann, darf Sicherheit nicht nachträglich behandelt werden — größere Fähigkeiten erhöhen den Schadenradius von Fehlern. Reale Deployments brauchen Governance: klare Nutzungsregeln, Logging und Auditierbarkeit, Zugriffskontrollen, Human‑in‑the‑Loop für sensible Workflows und Incident‑Response‑Pläne für unerwartetes Systemverhalten.

In hochrelevanten Produkten ist Alignment weniger Slogan und mehr Ingenieursdisziplin: Guardrails, Evaluationsmethoden, Monitoring und Verantwortlichkeit. Fähigkeit erzeugt Aufmerksamkeit; Sicherheit schafft Vertrauen.

Können LLM‑basierte Systeme AGI werden? Was müsste sich ändern

Die Schlüsselfrage ist nicht, ob ein LLM durch Anhängen von Tools „upgegradet" werden kann. Es geht darum, ob Wahrnehmung, Gedächtnis und Handlung die fundamentalen Lücken schließen: verlässliches Schließen, geerdetes Verständnis und kohärentes, langfristiges Verhalten.

Werkzeuge helfen — aber sie erzeugen kein Verständnis per Zauber

Hybride Systeme wirken schon heute deutlich fähiger als reine Chat‑Modelle. Ein LLM, das suchen, Dokumente abrufen, Code ausführen, APIs anrufen und seine Arbeit prüfen kann, erscheint in vielen Aufgaben intelligenter. Praktisch reduziert dieser Ansatz Fehler: Retrieval kann Antworten in autoritäre Quellen verankern, Ausführung kann Mathe und Logik verifizieren.

Werkzeugnutzung ändert jedoch meist die Performance, nicht die Natur der Kognition des Modells. Das LLM bleibt ein probabilistischer Textgenerator; das umgebende System muss es einschränken, validieren und entscheiden, wann Vertrauen angebracht ist.

Was Systeme wirklich näher an AGI bringen würde

Wenn wir Labels vermeiden und über Architekturen sprechen, sind mehrere Änderungen relevanter als bloß größere Modelle:

- Geerdete Weltmodelle: Lernen, das an Wahrnehmung und Interaktion gebunden ist, nicht nur an Text.

- Verifizierte Reasoning‑Pipelines: systematische Prüfungen (Ausführung, formale Methoden, Beweise, Konsistenztests) als Standard.

- Persistentes Gedächtnis mit Governance: dauerhafte, editierbare Wissensbestände und nutzerspezifischer Kontext ohne unkontrolliertes Driften oder Privatsphäre‑Risiken.

- Planung und Kontrollschleifen: explizite Zielzerlegung, Überwachung und Recovery bei Fehlern über lange Zeiträume.

- Training für Wahrheit und Kalibrierung: Systeme, die angemessen enthalten können und verlässlich Unsicherheit signalisieren.

Warum „Capability‑first" nützlicher ist als „AGI"

„AGI" fasst viele Eigenschaften — Zuverlässigkeit, Autonomie, Transferfähigkeit, Robustheit, Sicherheit — in einem Wort zusammen. Systeme danach zu beschreiben, was sie tun können, unter welchen Bedingungen und mit welchen Fehlermodi, ist ehrlicher und nützlicher für Engineering und Risikomanagement. Es vermeidet auch die Versuchung, beeindruckende Demos mit allgemeiner, verlässlicher Intelligenz zu verwechseln.

Praktische Schlussfolgerungen für Unternehmen, die mit LLMs bauen

LLMs liefern heute echten Wert — wenn man sie als probabilistische Assistenten behandelt, nicht als autonome „Verständnismaschinen". Starke Deployments beginnen mit klarem Scope: welche Entscheidungen das Modell beeinflussen darf, was es niemals entscheiden darf und welche Belege es liefern muss, wenn es eine Antwort produziert.

Setzen Sie LLMs in assistiven Rollen mit Guardrails ein: Eingaben schützen (Privacy‑Filter, Prompt‑Templates, eingeschränkter Toolzugriff) und Ausgaben begrenzen (Formatprüfungen, Verankerung in internen Quellen, explizite Unsicherheit wo nötig). Für hochrelevante Workflows — Gesundheit, Finanzen, Recht, sicherheitskritische Operationen — erfordern Sie Human‑in‑the‑Loop‑Prüfung und erleichtern Sie die Überprüfung, indem Sie die relevante Quellkontextinformation neben dem Modellentwurf anzeigen.

Auditing ist eine einfache, aber oft übersehene Praxis: Ausgaben regelmäßig sampeln, Fehler kategorisieren (Halluzination, Auslassung, unsichere Empfehlung, Policy‑Verstoß) und diese Labels in Prompt‑Anpassungen, Retrieval‑Tuning, Routing‑Regeln und Evaluations‑Tests zurückspeisen.

Eine knappe Faustregel:

- Verwenden Sie LLMs für Entwürfe, Zusammenfassungen, Extraktion und Q&A über kontrolliertes internes Wissen.

- Verlassen Sie sich nicht auf sie als Quelle der Wahrheit oder für irreversible Freigaben und offene Automatisierung ohne Beschränkungen.

Wenn Sie diese Ideen in Produktionssoftware umsetzen — insbesondere in regulierten Domänen — konzentrieren sich Teams wie SaaS Production (saasproduction.com) oft auf Systemdesign statt Hype: KI‑Integration gepaart mit Human‑in‑the‑Loop‑Prüfung, strukturierten Checks und Nachvollziehbarkeit, sodass Tempogewinne nicht auf Kosten der Zuverlässigkeit gehen.

Häufig gestellte Fragen

What is an LLM in practical terms?

Ein LLM (Large Language Model) ist in erster Linie ein probabilistischer Textgenerator, der darauf trainiert ist, das nächste Token anhand von Mustern in großen Datensätzen vorherzusagen. Es ist sehr nützlich für sprachbezogene Aufgaben (Entwurf, Zusammenfassung, Übersetzung, Unterstützung beim Programmieren), aber das liefert nicht automatisch: - eine in der realen Welt verwurzelte Verständnisbasis - verlässliche Wahrheitsprüfung - dauerhafte Ziele oder selbstgesteuertes Verhalten über die Zeit

What do people usually mean by AGI?

AGI wird typischerweise als breit einsetzbare Intelligenz verstanden, die in vielen Umgebungen auf (oder über) dem menschlichen Niveau lernen und handeln kann, mit verlässlicher Schlussfolgerungskompetenz und der Fähigkeit, über Zeit ohne ständige menschliche Stützung zu operieren. In der Praxis impliziert das Robustheit, Fähigkeitserwerb, Planung und konstante Leistung in wirklich neuen Situationen — nicht nur flüssige Antworten.

Why do debates about “LLMs vs. AGI” get so confused?

Weil „Generalisierung" unterschiedliche Bedeutungen hat. Ein Modell kann auf neue Formulierungen bekannter Aufgaben generalisieren (eine Stärke vieler LLMs), aber dennoch scheitern bei: - dem Transfer von Fähigkeiten in neue Domänen mit neuen Regeln - der Anpassung basierend auf realem Feedback - der Aufrechterhaltung der Korrektheit bei Randfällen und Verteilungsverschiebungen

What is the “grounding gap,” and why does it matter?

Grounding ist die Verbindung zwischen Symbolen (Wörtern) und realer Wahrnehmung/Handlung/Feedback. Menschen lernen Konzepte durch Interaktion (wahrnehmen → handeln → beobachten → aktualisieren). Ein rein textbasiertes Modell kann die Welt überzeugend beschreiben, hat aber keinen direkten Weg, um zu überprüfen, was *jetzt gerade* in einer konkreten Umgebung wahr ist — das ist ein zentrales Defizit für verlässliche Autonomie.

Why do LLMs hallucinate even when they sound confident?

Halluzinationen entstehen, weil das Modell auf *plausible Fortsetzung* optimiert ist, nicht auf garantierte Wahrheit. Fehlen die nötigen Informationen im Prompt (oder sind sie mehrdeutig), produziert das Modell möglicherweise trotzdem eine antwort‑ähnliche Ausgabe, die gut klingt. Betriebliche Gegenmaßnahmen umfassen häufig: - Zitate aus genehmigten internen Quellen verlangen - Retrieval aus vertrauenswürdigen Datenspeichern - deterministische Validierung (Schemata, Regeln, Unit‑Tests) - Human‑in‑the‑Loop‑Prüfung für hochrelevante Ausgaben

Why are LLM outputs so sensitive to prompt wording?

Das Verhalten eines LLMs kann sich bei kleinen Prompt‑Änderungen deutlich ändern — andere Wortwahl, Reihenfolge von Beschränkungen oder versteckter Kontext in einem langen Chat können die Ausgabe beeinflussen. Das ist ein Hinweis darauf, dass man mit einem kontextsensitiven Generator interagiert und nicht mit einer stabilen "Schlussmaschine". Zur Reduktion der Fragilität: - Templates mit konsistenter Struktur verwenden - Anforderungen explizit und testbar halten - automatische Prüfungen (Format, Constraints, Invarianten) hinzufügen - mit einem festen Testset evaluieren, bevor Änderungen live gehen

Do LLMs actually reason, or just mimic reasoning?

Nicht zuverlässig. LLMs können Schlussfolgerungen imitieren und oft brauchbare Kandidat‑Lösungen vorschlagen, aber sie lassen oft Verifikation aus, driften in langen Ketten oder brechen bei seltenen Beschränkungen zusammen. Ein sichereres Muster ist: - das LLM Optionen generieren lassen - mit Tools verifizieren (ausgeführter Code, Rechner, Solver) - Korrektheit durch Tests und Reviews erzwingen - die finale Entscheidung als kontrolliertes Systemergebnis behandeln, nicht als freie Completion

What’s the difference between a chat model and an “agent”?

Per Default sind die meisten LLMs reaktiv: Sie antworten auf Prompts, behalten aber keine Ziele oder Persistenz, es sei denn, das umgebende System liefert Speicher, Werkzeuge und eine Kontrollschleife. Agentenhaftes Verhalten entsteht, wenn man das Modell in eine Architektur mit Task‑Queues, Tools, Speichern, Planern und Evaluatoren einbettet. Das erhöht jedoch auch die potenzielle Schadenswirkung gewöhnlicher Fehler. Praktische Schutzmaßnahmen sind Minimalrechte für Tools, Freigaben für irreversible Aktionen, Monitoring und klare Eskalationswege.

Why don’t LLMs have real long-term memory or consistent identity?

Was oft als „Gedächtnis" bezeichnet wird, ist meist nur der Text, der noch im Kontextfenster steht. Fällt dieser Text heraus, „erinnert" sich das Modell nicht — es schätzt, was plausibel wäre. Für Kontinuität fügen Teams externe Zustände hinzu: - strukturierten Task‑State (Entscheidungen, Constraints, offene Fragen) - Retrieval aus geprüften Dokumenten - Benutzerpräferenzen und Berechtigungen außerhalb des Modells Selbst dann braucht es Governance (was gespeichert wird, wer Zugang hat, wie Korrekturen erfolgen) und Prüfungen auf Fehlabruf oder Fehlinterpretation.

How should businesses use LLMs safely in production (especially in regulated domains)?

Konzentrieren Sie sich auf Fähigkeiten und Fehlermodi und bauen Sie das System darum herum: - Nutzen Sie LLMs für Entwürfe, Zusammenfassungen, Extraktion und Q&A über kontrolliertes internes Wissen. - Verwenden Sie sie nicht als alleinige Wahrheitsquelle für medizinische, rechtliche, finanzielle oder Compliance‑Freigaben. - In Gesundheits‑ und EMR/EHR‑nahen Workflows: Nachvollziehbarkeit, Audit‑Logs und Human‑in‑the‑Loop‑Prüfung verlangen. - Deterministische Schutzmechanismen hinzufügen (Schemata, Regeln, Unit/Integration‑Tests) und routinemäßiges Output‑Auditing. Ziel ist Geschwindigkeit *mit* Zuverlässigkeit: Betrachten Sie das Modell als Komponente in einem verifizierten Workflow, nicht als autonome Autorität.

Can LLMs become more capable by using tools?

Hybrid‑Systeme wirken oft fähiger als reine Chat‑Modelle. Ein LLM, das suchen, Dokumente abrufen, Code ausführen, APIs aufrufen und seine Arbeit prüfen kann, erscheint in vielen Aufgaben „smarter". Aber Werkzeugnutzung verändert meist die *Performance*, nicht die kognitive Natur des Modells. Das LLM bleibt ein probabilistischer Textgenerator; das umgebende System muss es einschränken, validieren und entscheiden, wann ihm vertraut wird.

Why is verified reasoning important beyond fluent output?

Weil das Modell Muster bevorzugt, die in den Trainingsdaten wahrscheinlich sind, liest es oft Antworten ab, die sprachlich korrekt erscheinen, aber nicht gründlich überprüft wurden. Wenn eine Aufgabe strikte, langlaufende Korrektheit erfordert oder frühe Fehler stark weiterwirken, sind allein fluide Texte keine Garantie. Deshalb sind verifizierende Pipelines (Ausführung, formale Methoden, Tests) und Monitoring entscheidend, um Vorschläge in verlässliche Ergebnisse zu verwandeln.

What would it take for LLM-based systems to move meaningfully closer to AGI?

Wenn man über Architekturen spricht, sind mehrere Verschiebungen relevanter als bloß größere Modelle: - Grounded World Models: Lernen, das an Wahrnehmung und Interaktion gebunden ist, nicht nur an Text. - Verifizierte Reasoning‑Pipelines: systematische Prüfungen (Ausführung, formale Methoden, Konsistenztests) als Standard. - Persistenter Speicher mit Governance: dauerhafte, editierbare Wissensbasen und nutzerspezifischer Kontext ohne unkontrolliertes Driften. - Planungs‑ und Kontrollschleifen: explizite Zielzerlegung, Überwachung und Recovery über lange Horizonte. - Training für Wahrheit und Kalibrierung: Systeme, die angemessen enthalten können und verlässlich Unsicherheit signalisieren.