Por qué los LLM no son AGI: límites, mitos y qué sigue

Los modelos de lenguaje grandes parecen inteligentes, pero carecen de objetivos, anclaje y razonamiento fiable. Explora límites clave, mitos y vías realistas a seguir.

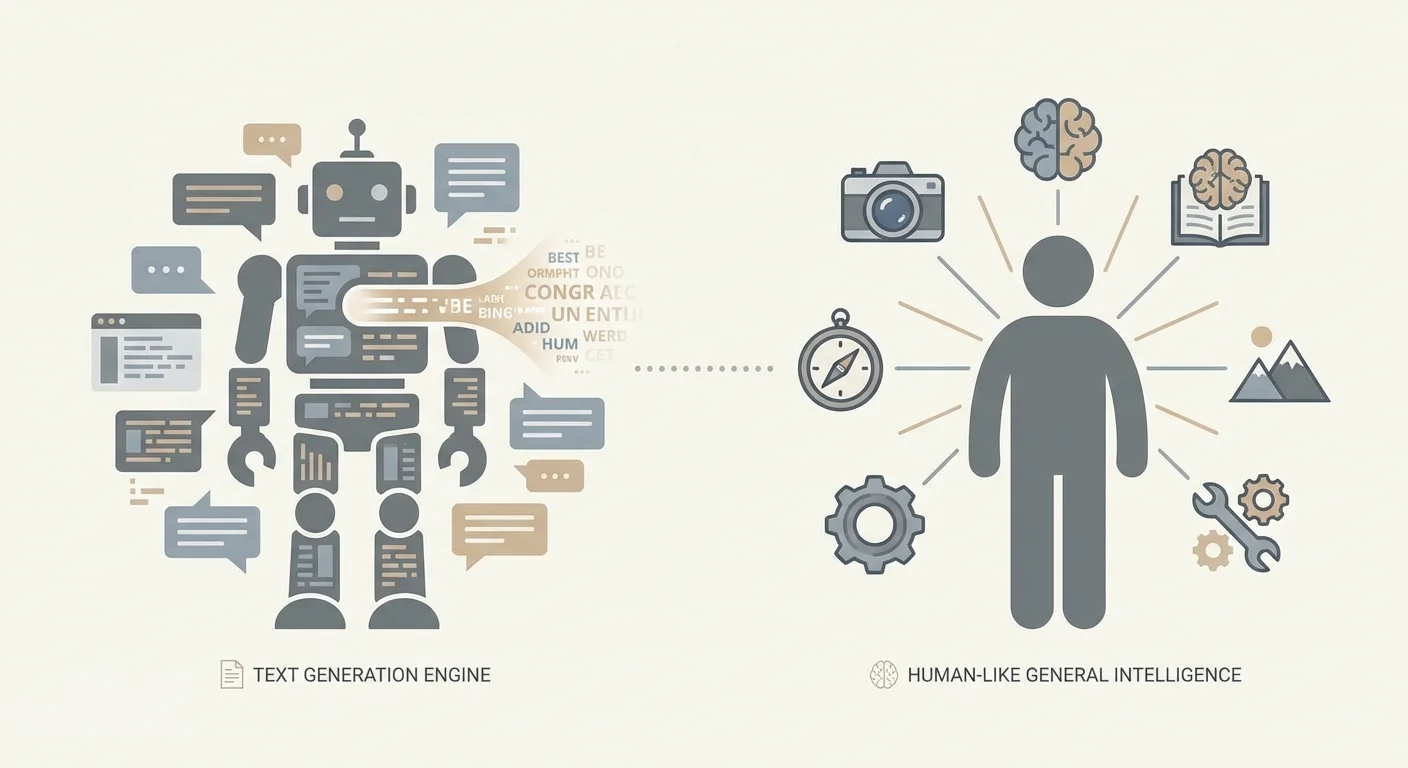

LLM vs. AGI: qué entendemos por estos términos

Gran parte del argumento “los LLM son (o no son) AGI” es, en realidad, un problema de terminología. La gente usa las mismas palabras para cosas distintas y termina hablando de lado. Antes de debatir lo que pueden hacer los sistemas actuales, conviene fijar los términos.

Un LLM (Large Language Model) es un modelo entrenado para predecir y generar texto (y a veces otras modalidades) a partir de patrones en grandes conjuntos de datos. Puede ser notablemente capaz explicando, resumiendo, traduciendo, programando y conversando—porque esas tareas encajan bien con la predicción lingüística. Esa capacidad por sí sola no implica una comprensión estable del mundo, objetivos duraderos o la habilidad de operar de forma independiente.

IA estrecha describe sistemas que rinden bien en dominios o familias de tareas específicas—filtros de spam, clasificadores de imágenes médicas, optimización de rutas y (en buena parte) la mayoría de despliegues actuales de LLM. Los sistemas estrechos pueden ser extremadamente potentes y económicamente importantes sin ser “generales”.

AGI (Inteligencia Artificial General) es un término más difuso, pero la idea práctica es un agente que puede aprender y rendir en una amplia gama de tareas y entornos al nivel humano (o más), con razonamiento fiable, capacidad para adquirir nuevas habilidades y competencia para actuar en el tiempo sin un andamiaje humano constante.

Incluso “generalización” puede significar cosas distintas. A veces significa hacerlo bien con nuevas formulaciones de tareas familiares; otras, transferir habilidades entre dominios; y otras, adaptarse a situaciones genuinamente novedosas con mínima guía. No son equivalentes. Los LLM pueden sobresalir en lo primero y aun así tener problemas con lo último.

Este debate importa porque se toman decisiones reales según él. Empresas pueden sobre-automatizar flujos críticos, reguladores pueden enfocar mal políticas y equipos pueden subinvertir en controles de seguridad. En entornos de alto riesgo—como desarrollo de software y flujos clínicos (incluyendo contextos EMR/EHR)—la salida confiada de un LLM puede parecer competencia hasta que falla en un caso límite donde la corrección y la trazabilidad son innegociables.

Este artículo no sostiene que los LLM sean inútiles o “solo autocompletado”. Sostiene que la fluidez no es lo mismo que la inteligencia general, y que los LLM actuales tienen límites estructurales que los dejan cortos respecto a AGI.

Finalmente, “nunca” es una afirmación fuerte. Trátala aquí no como profecía, sino como estímulo: ¿qué tendría que cambiar—arquitectónicamente y a nivel de sistema—para que un enfoque basado en LLM contara como AGI en un sentido significativo?

Cómo funcionan los LLM (sin la exageración)

Los Modelos de Lenguaje Grandes son, en el fondo, predictores de texto extremadamente capaces. Se entrenan con vastas colecciones de texto y aprenden regularidades estadísticas: qué secuencias de palabras tienden a seguirse, cómo se expresan comúnmente las ideas y qué estilos encajan en cada contexto. Cuando das un prompt a un LLM, no “consulta” una respuesta almacenada ni un modelo del mundo de la manera que muchos imaginan. Genera el siguiente token (un fragmento de texto) más plausible dado lo anterior y repite el paso.

Entrenamiento: aprender patrones, no hechos garantizados

Durante el entrenamiento, el modelo ve una secuencia de tokens y se le pide predecir el siguiente. Con muchos ejemplos, ajusta parámetros internos para mejorar sus predicciones. Esto crea una habilidad impresionante para continuar texto de formas coherentes—porque la coherencia está fuertemente correlacionada con los patrones del entrenamiento.

Aumentar datos y cómputo suele mejorar la fluidez y versatilidad por una razón simple: el modelo puede representar más patrones y ajustarlos con mayor precisión. Con suficiente capacidad maneja construcciones más raras, sigue contextos más largos e imita estilos especializados. Nada de eso garantiza una comprensión estable y anclada de lo que dice; indica que el modelo se ha vuelto muy bueno en completar patrones.

Habilidades “emergentes”: sorprendentes, pero no mágicas

Algunas capacidades parecen aparecer “de repente” en tamaños mayores—explicaciones en varios pasos, ayuda básica de programación o mayor consistencia siguiendo instrucciones. A menudo lo que ocurre es menos misterioso: el modelo combina patrones familiares de nuevas formas, transfiere una habilidad vista en muchas formas adyacentes o se vuelve lo bastante fiable como para que los usuarios lo noten.

Estos saltos pueden sentirse dramáticos, pero siguen siendo consistentes con la predicción del siguiente token como objetivo subyacente.

Por qué la conversación nos engaña

Las interfaces conversacionales fomentan una interpretación humana: la confianza suena a conocimiento; un tono servicial suena a intención; una explicación bien estructurada suena a razonamiento. Pero la habilidad conversacional no es lo mismo que comprensión, objetivos o seguimiento de la verdad. En despliegues prácticos, la postura más segura es tratar la salida del LLM como un borrador sólido—no como una autoridad.

El texto no es el mundo: la brecha de anclaje

Un modelo de lenguaje puede producir descripciones convincentes de la realidad sin haber estado en la realidad. El texto es un registro de la experiencia humana—resúmenes, historias, instrucciones, argumentos—no la experiencia misma. Cuando un LLM predice la siguiente palabra puede sonar a que “entiende”, pero puede estar simplemente ensamblando patrones que correlacionan con la comprensión más que con la aprehensión causal y perceptiva que usan los humanos para navegar el mundo.

Qué significa “anclaje”

El anclaje es la conexión entre símbolos (palabras, números, etiquetas) y algo fuera de los símbolos: percepción, acción y retroalimentación. Los humanos aprenden lo que significa “caliente” tocando una taza, sintiendo el calor y recordándolo. Refinamos “pesado” al levantar, fallar, ajustar el agarre y volver a intentar. Ese bucle—sentir, actuar, observar consecuencias—ancla conceptos en la realidad.

Un modelo de solo texto carece de ese bucle. Puede recitar que “el vidrio se rompe al caer”, pero no posee la expectativa de una forma que se actualice cuando cambian las condiciones (vidrio grueso, suelo de goma, poca altura). Normalmente no tiene un canal directo para verificar qué es verdadero ahora, en esta situación, bajo estas restricciones.

Dónde falla “saber palabras sobre cosas”

Los patrones solo en lenguaje son un sustituto pobre del contacto con el mundo en varias situaciones comunes. La causalidad física suele requerir ponderar múltiples factores interactivos en lugar de emparejar una palabra clave. El razonamiento espacial puede fallar cuando las instrucciones dependen de rotaciones, relaciones 3D consistentes o mapear palabras a un entorno específico. Los contextos en tiempo real—estados de inventario, lecturas de sensores, condición de pacientes—son especialmente riesgosos porque la “respuesta típica” de ayer puede ser activamente peligrosa. Y las situaciones genuinamente nuevas exponen la limitación central: adivinar lo que suena bien no es lo mismo que acertar.

Por qué esta brecha es central para AGI

AGI implica competencia flexible a través de entornos, no solo comentarios elocuentes sobre ellos. Sin anclaje, un LLM puede ser un asistente poderoso, pero sigue siendo vulnerable a errores confiados cuando el mundo exige verificación, experimentación o incertidumbre calibrada.

Por eso muchos sistemas prácticos emparejan LLM con herramientas: bases de datos, sensores, simuladores y controles humanos. En trabajo aplicado—especialmente en flujos clínicos o sistemas empresariales sensibles a la seguridad—anclar no es filosófico; es la diferencia entre un borrador útil y una salida en la que puedes confiar.

Fiabilidad: alucinaciones, fragilidad y verdad

Los LLM pueden sonar seguros incluso cuando están equivocados. Estas fallas se llaman a menudo alucinaciones: salidas fluidas, detalladas y afirmadas con confianza—pero no fundadas en hechos verificados. Lo más difícil es que el tono suele ser indistinguible de una respuesta correcta, así que mirar por encima no es una estrategia fiable.

Por qué el texto fluido puede separarse de la verdad

Un LLM se entrena para predecir el token más probable dado su contexto. Ese objetivo recompensa la plausibilidad—lo que típicamente sigue en textos similares—más que la búsqueda de la verdad. Si el modelo carece de la información necesaria, puede aún producir una conjetura que coincida con el patrón de una respuesta. Y aun cuando la información correcta exista en los datos de entrenamiento, el modelo no la recupera como una base de datos; muestrea desde una distribución de probabilidad aprendida. Como resultado, la corrección y el objetivo de entrenamiento pueden entrar en conflicto.

Fragilidad ante cambios pequeños

La fiabilidad también se rompe de maneras más sutiles. Pequeñas ediciones del prompt—redacción, orden, restricciones adicionales—pueden producir conclusiones significativamente distintas. Restricciones ocultas, como historial largo de chat o requisitos ambiguos, pueden dirigir la salida sin que el usuario lo note. Esta brittleness indica que no interactúas con un “motor de razonamiento” estable, sino con un generador sensible cuyo comportamiento depende mucho del contexto.

Soporte a la decisión vs. toma de decisiones

Debido a las alucinaciones y la fragilidad del prompt, los LLM son mejores como soporte a la decisión: redactar, resumir, generar ideas, traducir lenguaje de dominio y proponer opciones. En el momento en que les permites tomar decisiones—aprobar un cambio en un flujo médico, firmar una declaración de cumplimiento o finalizar lógica financiera—heredas un modo de fallo que puede ser sutil y persuasivo.

En entornos de producción, los equipos reducen este riesgo anclando respuestas en fuentes confiables o datos estructurados, exigiendo fragmentos de evidencia dentro del flujo (no solo afirmaciones confiadas), envolviendo pasos críticos en validaciones deterministas (esquemas, reglas, tests unitarios) y manteniendo revisión Humana-en-el-Bucle para acciones de alto impacto.

La fiabilidad no es hacer que los modelos “suenen más inteligentes”. Es diseñar sistemas donde sonar correcto nunca sea suficiente.

Razonamiento no está garantizado por la fluidez

Un malentendido persistente es que si un modelo puede sonar como si razona, entonces debe razonar. Los LLM generan el siguiente token que mejor encaja con los patrones de entrenamiento y el contexto inmediato. Ese proceso puede imitar lógica paso a paso—a veces de forma impresionante—sin imponer de forma fiable las restricciones que el razonamiento real requiere: consistencia, exhaustividad y comprobación de errores.

Dónde el “razonamiento” de un LLM se siente real

Los LLM suelen funcionar bien cuando las buenas respuestas están fuertemente correlacionadas con patrones lingüísticos familiares: redactar explicaciones, resumir compensaciones, proponer soluciones plausibles o producir código que se parezca a implementaciones comunes. Incluso cuando el modelo no prueba nada, puede ser un motor heurístico eficaz: sugiere enfoques que un humano puede validar.

Dónde la fluidez se viene abajo

El problema aparece cuando la tarea exige corrección estricta a largo plazo más que una narración plausible. La lógica en varios pasos puede colapsar cuando un error temprano contamina todo lo sucesivo. Problemas tipo demostración requieren restricciones herméticas, no prosa persuasiva. Los casos límite y condiciones raras pueden estar pobremente representados en el texto de entrenamiento. Los conflictos entre instrucciones, supuestos y dependencias ocultas pueden tirar la finalización en direcciones inconsistentes. Y las respuestas con forma de “respuesta” pueden saltarse la verificación precisamente porque suenan bien.

Por qué importan las herramientas y capas de verificación

La imagen cambia cuando el LLM es un componente dentro de un sistema que puede comprobarse a sí mismo. Herramientas externas (calculadoras, intérpretes, solvers formales), recuperación de datos autorizados y verificación estructurada (tests unitarios, comprobaciones de consistencia, crítica cruzada entre modelos, revisión Humana-en-el-Bucle) pueden convertir sugerencias fluidas en resultados confiables.

Eso no convierte al modelo base en un AGI. Lo convierte en una interfaz potente para generar candidatos—mientras que el resto del sistema hace el trabajo de anclaje y corrección.

Agencia y objetivos: los ingredientes que faltan

Cuando la gente imagina AGI, suele visualizar algo con agencia: capaz de formarse objetivos, mantenerlos en el tiempo, planear acciones para alcanzarlos, observar lo ocurrido y ajustarse con base en la retroalimentación. La agencia no es solo “hacer tareas”. Es comportamiento persistente y autodirigido a través de situaciones cambiantes.

La mayoría de los LLM, por defecto, no tienen eso. Un modelo de chat genera el siguiente token dado el prompt. Puede hablar sobre metas, planes e intenciones con fluidez impresionante, pero intrínsecamente no desea nada y no persigue objetivos cuando la conversación termina. Sin un bucle externo no tiene un objetivo estable, retroalimentación continua ni mecanismo para decidir qué hacer más allá de responder.

Chat completion vs. sistemas agenticos

Un montaje de chat es reactivo: preguntas, responde. Una arquitectura agentica envuelve el modelo en un andamiaje que provee persistencia y control—colas de tareas, herramientas (APIs), almacenes de memoria, planificadores y evaluadores que comprueban resultados. En ese montaje, el sistema exhibe comportamiento parecido a la agencia; el modelo de lenguaje es un componente.

Esta distinción importa en la práctica. Si un “asistente AI” puede programar tareas, modificar registros o desencadenar despliegues, la parte más arriesgada no es la habilidad de escritura del modelo: son los permisos y el bucle de decisión que lo rodea.

Por qué añadir agencia eleva los riesgos

Dar acceso a herramientas y autonomía a un modelo puede amplificar los modos de fallo ordinarios. Puede perseguir un objetivo equivocado, sobrerinterpretar instrucciones vagas o actuar con supuestos incorrectos. La solución no es “un modelo más inteligente” a secas; son salvaguardas: especificaciones claras de objetivos, acceso a herramientas restringido, aprobaciones para acciones de alto impacto, monitorización y evaluación rigurosa frente a resultados reales.

Memoria, identidad y continuidad en el tiempo

Los LLM pueden sonar consistentes dentro de una sola conversación, pero esa “continuidad” suele ser una ilusión creada por una ventana de contexto a corto plazo. Dentro de esa ventana, el modelo puede referirse a lo que dijiste y mantener un tono coherente. Fuera de ella—a lo largo de sesiones, días o tareas del mundo real—no hay un yo duradero, creencias estables ni comprensión persistente de tus objetivos.

Contexto corto no es memoria a largo plazo

Lo que la gente llama “memoria” en un LLM suele ser simplemente texto aún visible en el prompt. Es más parecido a la memoria de trabajo que a un registro vital. Una vez que los detalles anteriores salen de la ventana de contexto, el modelo no los recuerda; conjetura qué sería plausible.

La inteligencia general, como la imagina la gente, depende de continuidad: aprender de errores, acumular hechos fiables, revisar creencias y mantenerse alineada con objetivos a largo plazo aun cuando la conversación se reinicia.

Deriva de identidad y preferencias

Sin estado persistente, los LLM pueden contradecirse entre sesiones: una herramienta que “prefiere” un enfoque hoy puede recomendar lo opuesto mañana, no porque haya actualizado su visión, sino porque está muestreando una finalización distinta. Incluso dentro de la misma sesión, pequeños cambios en el prompt pueden producir prioridades cambiantes o una nueva interpretación de lo que el usuario quiso decir.

Esa fragilidad importa para tareas reales—recogida de requisitos, documentación médica, proyectos de software de varias semanas—donde la consistencia y la trazabilidad son tan importantes como la elocuencia.

Añadir memoria con recuperación y estado estructurado (y lo que no resuelve)

Para compensar, los equipos añaden memoria externa: sistemas de recuperación, bases de datos, perfiles de usuario y estado estructurado que se reinyecta en el prompt. Esto puede mejorar dramáticamente la continuidad y es común en sistemas de producción.

Capas típicas incluyen resúmenes de conversación, recuperación de documentos o bases de conocimiento, perfiles de preferencias y permisos almacenados en una base de datos, y estado de tarea estructurado (decisiones tomadas, preguntas abiertas, restricciones). Pero son andamiajes alrededor del modelo, no una identidad interna que se mantiene sola. La recuperación puede sacar el hecho equivocado, los resúmenes pueden borrar matices y el modelo puede seguir interpretando mal el estado almacenado.

En la práctica, el comportamiento fiable a largo plazo suele requerir diseño cuidadoso del sistema más revisión Humana-en-el-Bucle.

Generalización más allá de la distribución de entrenamiento

Si alguna vez existe AGI, debe hacer más que rendir bien en patrones familiares. Debería transferir lo que sabe a dominios realmente nuevos, reglas y objetivos, especialmente cuando la “respuesta correcta” no puede hallarse simplemente rehaciendo ejemplos pasados.

Generalización vs. “parecer lo bastante similar”

Mucho del éxito de los LLM se describe mejor como interpolación potente: producir salidas coherentes con la estructura estadística de los datos que absorbieron. Cuando una tarea se parece a formatos comunes de entrenamiento—explicaciones, resúmenes, patrones de código, guiones de atención al cliente—los LLM pueden parecer ampliamente capaces.

Pero interpolación no es generalización en el sentido de AGI. Un modelo puede ser excelente completando patrones y aun así fallar cuando la tarea exige aprender una regla nueva al vuelo, construir un modelo interno estable de un entorno desconocido o actualizar creencias cuando observaciones contradicen la suposición inicial.

Fallos fuera de distribución no son casos marginales

El trabajo real crea constantemente situaciones fuera de distribución: nuevas regulaciones, restricciones de producto, comportamiento inesperado de usuarios, interfaces de herramientas que cambian, conjuntos de datos con esquemas novedosos. Los LLM suelen degradarse de forma marcada cuando cambia la forma superficial o cuando el éxito depende de restricciones ocultas más que de plausibilidad textual.

Los problemas suelen aparecer cuando reglas nuevas contradicen convenciones comunes, cuando las acciones importan más que la redacción (uso de herramientas en varios pasos bajo restricciones), cuando aparecen combinaciones raras de conceptos o cuando las instrucciones son adversariales o ambiguas—condiciones donde “sonar correcto” es fácil y acertar es difícil.

Por qué los benchmarks pueden sobreestimar la capacidad

Los benchmarks son útiles, pero a menudo se optimizan para comparabilidad, no para sorpresa. Una vez que un benchmark se vuelve popular, moldea el entrenamiento, las estrategias de prompting y las normas de evaluación. Las puntuaciones suben mientras la verdadera pregunta—“¿manejará lo próximo que no pensamos probar?”—permanece.

Para las empresas, esta brecha es operacional: un sistema puede parecer “tipo AGI” en demos internas y fallar cuando un flujo de cliente se desvía del conjunto de pruebas. Los sistemas de producción necesitan interfaces restringidas, pasos de verificación y escalado humano ante casos verdaderamente novedosos.

Alineación y seguridad: la capacidad no basta

Cuando la gente afirma que un modelo muy capaz es “básicamente AGI”, suele fijarse en lo que puede hacer en una demo. La alineación plantea otra pregunta: ¿el sistema persigue de forma fiable la intención del usuario dentro de los límites humanos, incluso cuando el prompt es ambiguo, adversarial o moralmente complejo?

En la práctica, la alineación significa empatar metas (lo que el usuario quiere), valores (lo que la sociedad permite) y límites (privacidad, legalidad, políticas de seguridad, reglas operativas) en situaciones desordenadas.

Por qué RLHF ayuda—y por qué no lo resuelve

El ajuste por instrucciones y RLHF (aprendizaje a partir de retroalimentación humana) pueden hacer a un modelo más cooperativo y menos tóxico. Pero no lo convierten en un razonador consistentemente principiado. El sistema sigue aprendiendo patrones de respuestas preferidas, no una comprensión profunda de valores humanos.

La alineación tampoco es un único objetivo. Balanceas ideales que pueden entrar en conflicto: utilidad, honestidad, seguridad, privacidad y equidad. Optimizar uno presiona a los otros. Un modelo entrenado para ser extremadamente “útil” puede sobre-responder y especular; uno afinado para seguridad estricta puede rechazar solicitudes benignas; uno muy cauto puede frustrar a usuarios y empujarlos a soluciones peligrosas.

Por qué las afirmaciones de AGI deben incluir gobernanza

Si “AGI” significa un sistema que puede actuar ampliamente y con competencia, la seguridad no puede ser un añadido tardío—mayor capacidad aumenta el radio de impactos de los errores. Los despliegues reales necesitan gobernanza: políticas claras sobre usos permitidos, registro y auditabilidad, control de accesos, revisión Humana-en-el-Bucle para flujos sensibles y respuesta a incidentes cuando el sistema se comporta inesperadamente.

En productos de alto riesgo, la alineación es menos eslóganes y más disciplina de ingeniería: salvaguardas, evaluaciones, monitorización y responsabilidad. La capacidad atrae atención; la seguridad genera confianza.

¿Pueden los sistemas basados en LLM convertirse en AGI? ¿Qué tendría que cambiar?

La pregunta clave no es si un LLM puede “mejorarse” hasta AGI añadiendo herramientas. Es si añadir percepción, memoria y acción cierra las brechas fundamentales: razonamiento fiable, comprensión anclada y comportamiento coherente a largo plazo.

Las herramientas ayudan—pero no crean comprensión mágica

Los sistemas híbridos ya parecen mucho más capaces que un modelo solo de chat. Un LLM que puede buscar, recuperar documentos, ejecutar código, llamar APIs y comprobar su trabajo parecerá “más inteligente” en muchas tareas. En la práctica, este enfoque reduce errores: la recuperación ancla respuestas en fuentes autorizadas y la ejecución puede verificar cálculos y lógica.

Pero el uso de herramientas cambia sobre todo el desempeño, no la naturaleza de la cognición central del modelo. El LLM sigue siendo un generador probabilístico de texto; el sistema circundante debe limitarlo, validarlo y decidir cuándo confiar en él.

Qué movería a los sistemas más cerca de AGI de forma significativa

Si evitamos etiquetas y hablamos de arquitecturas, varios cambios importan más que simplemente hacer modelos más grandes:

- Modelos de mundo anclados: aprendizaje ligado a percepción e interacción, no solo texto.

- Canales de razonamiento verificados: comprobaciones sistemáticas (ejecución, métodos formales, pruebas) por defecto, no como opción.

- Memoria persistente con gobernanza: conocimiento durable y editable y contexto específico del usuario sin deriva incontrolada ni riesgos de privacidad.

- Bucles de planificación y control: descomposición explícita de metas, monitorización y recuperación de fallos a horizontes temporales largos.

- Entrenamiento para verdad y calibración: sistemas que puedan abstenerse apropiadamente y señalar la incertidumbre de forma fiable.

Por qué es más seguro hablar en términos de capacidad que de “AGI”

“AGI” comprime muchas propiedades—fiabilidad, autonomía, transferencia, robustez, seguridad—en una sola palabra. Describir sistemas por lo que pueden hacer, bajo qué restricciones y con qué modos de fallo es más honesto y útil para la ingeniería y la gestión de riesgos. También evita la trampa común de confundir demos impresionantes con inteligencia general y fiable.

Conclusiones prácticas para empresas que construyen con LLM

Los LLM pueden ofrecer valor real hoy—si los tratas como asistentes probabilísticos, no como motores autónomos de “comprensión”. Los despliegues sólidos empiezan con alcance claro: qué decisiones puede influir el modelo, qué no debe decidir nunca y qué evidencia debe aportar cuando produce una respuesta.

Usa LLM en roles asistenciales con guardarraíles: protege entradas (filtros de privacidad, plantillas de prompt, acceso restringido a herramientas) y limita salidas (comprobaciones de formato, anclaje en fuentes internas cuando sea posible y expresión explícita de incertidumbre). Para flujos de alto impacto—salud, finanzas, legal, operaciones críticas—exige revisión Humana-en-el-Bucle y facilita el trabajo del revisor mostrando el contexto fuente relevante junto al borrador del modelo.

La auditoría es una práctica simple pero a menudo pasada por alto: muestrea salidas regularmente, etiqueta fallos (alucinación, omisión, sugerencia insegura, violación de política) y retroalimenta esas etiquetas en actualizaciones de prompt, ajuste de recuperación, reglas de ruteo y pruebas de evaluación.

Una regla práctica y concisa:

- Usa LLM para borradores, resúmenes, extracción y P y R sobre conocimiento interno controlado.

- No dependas de ellos como fuente de verdad ni para aprobaciones irreversibles o automatización abierta sin restricciones.

Si vas a convertir estas ideas en software de producción—especialmente en dominiios regulados—equipos como SaaS Production (saasproduction.com) suelen centrarse en el diseño del sistema más que en el bombo: integración de IA combinada con revisión Humana-en-el-Bucle, comprobaciones estructuradas y trazabilidad para que las ganancias de velocidad no vengan a costa de la fiabilidad.

Preguntas Frecuentes

¿Qué es un LLM en términos prácticos?

Un LLM (Large Language Model) es, en lo práctico, un generador probabilístico de texto entrenado para predecir el siguiente token a partir de patrones en grandes conjuntos de datos. Puede ser extremadamente útil para tareas con forma lingüística (redacción, resúmenes, traducción, asistencia de código), pero eso no implica automáticamente: - comprensión anclada del mundo real - seguimiento fiable de la verdad - objetivos duraderos o comportamiento autodirigido a lo largo del tiempo

¿Qué suele entender la gente por AGI?

Por lo general, AGI se entiende como una inteligencia con capacidad amplia que puede aprender y rendir en muchos entornos a nivel humano (o superior), con razonamiento fiable y la capacidad de operar en el tiempo sin un andamiaje humano constante. En la práctica implica robustez, adquisición de habilidades, planificación y rendimiento consistente en situaciones genuinamente nuevas—no solo respuestas fluidas.

¿Por qué los debates sobre “LLMs vs. AGI” se confunden tanto?

Porque “generalización” se usa para cosas distintas. Un modelo puede generalizar a nuevas redacciones de tareas familiares (a menudo fortaleza de los LLM) y aun así fallar en: - transferir habilidades a dominios con reglas nuevas - adaptarse en base a retroalimentación del mundo real - mantener corrección en casos límite y ante cambios de distribución

¿Qué es la “brecha de anclaje” y por qué importa?

El anclaje es la conexión entre símbolos (palabras) y la percepción/acción/retroalimentación del mundo real. Los humanos aprenden conceptos interactuando (sentir → actuar → observar → actualizar). Un modelo solo de texto puede describir el mundo con convicción sin tener una forma directa de verificar qué es cierto *ahora mismo* en un entorno específico, y esa carencia es central para la autonomía fiable.

¿Por qué los LLM alucinan aunque suenen confiados?

Las alucinaciones ocurren porque el modelo se optimiza para la *continuación plausible*, no para la verdad garantizada. Si la información necesaria no está en el prompt (o es ambigua), el modelo puede generar igualmente una respuesta con apariencia de respuesta correcta. Mitigaciones operativas habituales: - exigir citas de fuentes internas aprobadas (dentro del flujo de trabajo) - recuperación desde almacenes de datos fiables - validación determinista (esquemas, reglas, tests unitarios) - revisión Humana-en-el-Bucle para salidas de alto impacto

¿Por qué las salidas de los LLM son tan sensibles a la redacción del prompt?

El comportamiento de un LLM puede cambiar mucho con pequeñas ediciones del prompt, diferente orden de restricciones o contexto oculto en una conversación larga. Es señal de que estás interactuando con un generador sensible al contexto, no con una “máquina de razonar” estable. Para reducir la fragilidad: - usa plantillas con estructura consistente - mantén los requisitos explícitos y comprobables - añade verificaciones automáticas (formato, restricciones, invariantes) - evalúa con un conjunto de pruebas fijo antes de desplegar cambios

¿Los LLM realmente razonan o solo imitan el razonamiento?

No de forma fiable. Los LLM pueden imitar razonamiento paso a paso y proponer buenas soluciones candidatas, pero pueden omitir verificaciones, desviarse en cadenas largas o fallar ante restricciones raras. Un patrón más seguro es: - dejar que el LLM genere opciones - verificar con herramientas (código ejecutado, calculadoras, solucionadores) - hacer cumplir la corrección con pruebas y revisiones - tratar la decisión final como el resultado de un sistema controlado, no como una finalización libre

¿Cuál es la diferencia entre un modelo de chat y un “agente”?

Por defecto, la mayoría de los LLM son reactivos: responden a prompts pero no mantienen objetivos ni actúan a menos que un sistema envolvente les dé memoria, herramientas y un bucle de control. Añadir agencia (APIs, acceso de escritura, acciones automatizadas) aumenta el radio de impacto de los fallos. Salvaguardas prácticas: permisos con mínimo privilegio, aprobaciones para acciones irreversibles, monitorización y rutas claras de escalado.

¿Por qué los LLM no tienen memoria a largo plazo ni identidad consistente?

Lo que llaman “memoria” suele ser solo el texto aún visible en la ventana de contexto. Cuando sale de ella, el modelo no recuerda—adivina. Para lograr continuidad, los equipos añaden estado externo: - estado de tarea estructurado (decisiones, restricciones, preguntas abiertas) - recuperación desde documentos verificados - permisos y preferencias de usuario almacenados fuera del modelo Aun así, hace falta gobernanza (qué se almacena, quién accede, cómo se corrige) y comprobaciones contra recuperaciones o interpretaciones erróneas.

¿Cómo deben las empresas usar los LLM de forma segura en producción (especialmente en dominios regulados)?

Concéntrate en capacidades y modos de fallo, y diseña el sistema alrededor de ellos: - Usa LLM para borradores, resúmenes, extracción y P y R sobre conocimiento interno controlado. - No los uses como fuente de verdad para aprobaciones médicas, legales, financieras o de cumplimiento. - En salud y flujos adyacentes a EMR/EHR, exige trazabilidad, registros de auditoría y revisión Humana-en-el-Bucle. - Añade salvaguardas deterministas (esquemas, reglas, tests unitarios/integración) y auditoría rutinaria de salidas. La meta es velocidad con fiabilidad: trata al modelo como un componente dentro de un flujo verificado, no como una autoridad autónoma.