Pourquoi les LLM ne sont pas de l'AGI : limites, mythes et perspectives

Les grands modèles de langage donnent une impression d’intelligence, mais ils manquent d’objectifs, d’ancrage et de raisonnement fiable. Découvrez les limites clés, les mythes et les voies réalistes à suivre.

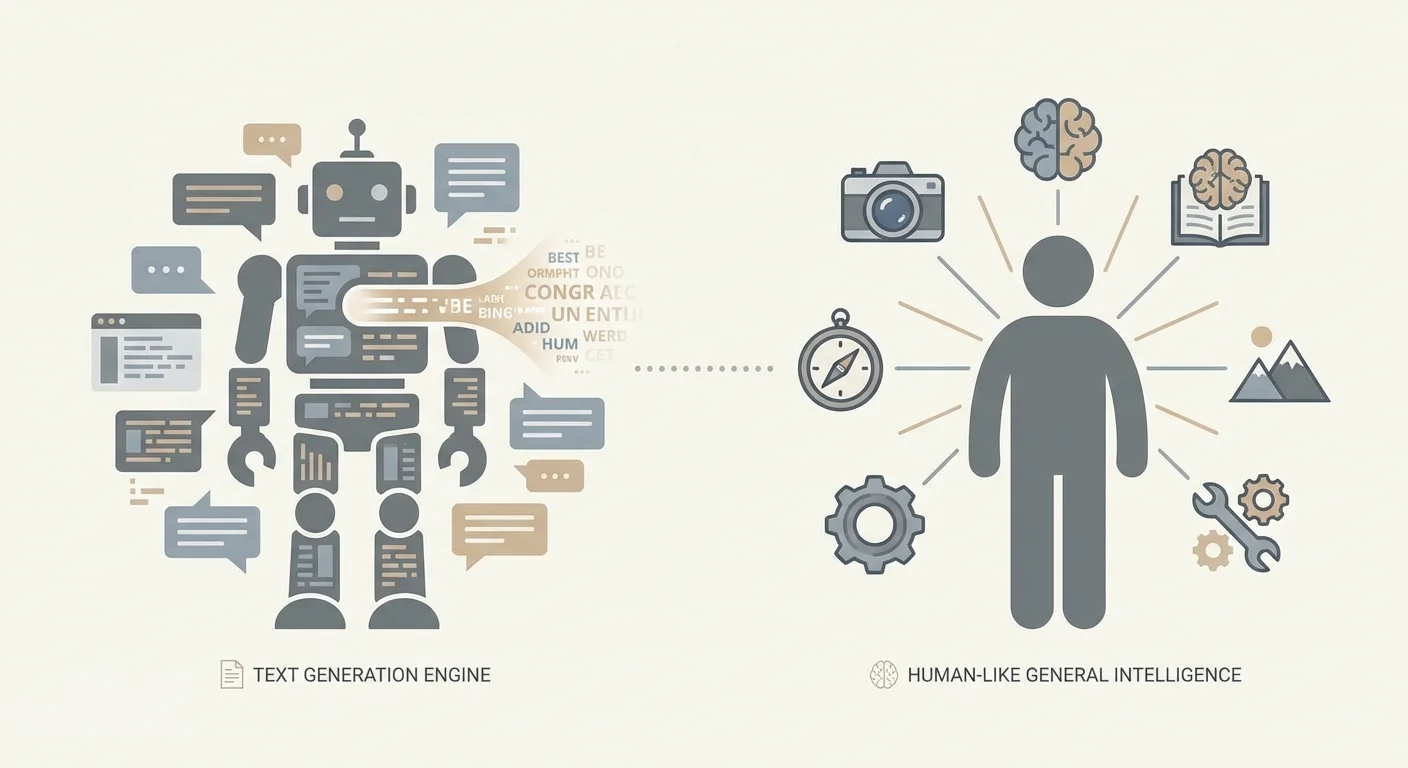

LLM vs. AGI : ce que nous entendons par ces termes

Beaucoup du débat « les LLM sont (ou ne sont pas) l’AGI » est en réalité un problème de terminologie. Les gens utilisent les mêmes mots pour dire des choses différentes, puis se parlent sans se comprendre. Avant de débattre de ce que les systèmes actuels peuvent faire, il est utile de préciser les termes.

Un LLM (Large Language Model) est un modèle entraîné pour prédire et générer du texte (et parfois d’autres modalités) à partir de motifs dans de larges jeux de données. Il peut être remarquablement capable pour expliquer, résumer, traduire, coder et converser — parce que ces tâches correspondent bien à la prédiction de langage. Cette capacité seule n’implique pas une compréhension stable du monde, des objectifs durables, ni la faculté d’agir de manière autonome.

IA étroite décrit des systèmes qui excellent dans des domaines ou familles de tâches spécifiques — filtres anti-spam, classifieurs d’images médicales, optimisation d’itinéraires, et (plutôt) la plupart des déploiements actuels de LLM. Les systèmes étroits peuvent être extrêmement puissants et économiquement importants sans être « généraux ».

AGI (Artificial General Intelligence) est un terme plus flou, mais l’idée pratique est un agent capable d’apprendre et d’agir sur une large gamme de tâches et d’environnements au niveau humain (ou au-delà), avec un raisonnement fiable, la capacité d’acquérir de nouvelles compétences et la compétence d’agir dans le temps sans échafaudage humain constant.

Même « généralisation » peut vouloir dire différentes choses. Parfois cela signifie bien fonctionner sur une nouvelle formulation d’une tâche familière ; parfois cela signifie transférer des compétences entre domaines ; parfois adapter à des situations vraiment nouvelles avec un guidage minimal. Ce ne sont pas des équivalences. Les LLM peuvent exceller dans le premier et encore échouer dans le dernier.

Ce débat importe parce que des décisions réelles en dépendent. Les entreprises peuvent sur-automatiser des flux critiques, les régulateurs mal cibler des politiques, et les équipes sous-investir dans les contrôles de sécurité. Dans des contextes à forte enjeu — comme le développement logiciel et les flux de soins de santé (y compris les contextes EMR/EHR) — la sortie confiante d’un LLM peut ressembler à de la compétence jusqu’à ce qu’il échoue sur un cas limite où exactitude et traçabilité sont non négociables.

Cet article n’affirme pas que les LLM sont inutiles ou « juste un autocomplétion ». Il soutient que la fluidité n’est pas la même chose que l’intelligence générale, et que les LLM d’aujourd’hui ont des limites structurelles qui les maintiennent en deçà de l’AGI.

Enfin, « jamais » est une affirmation forte. Prenez-la ici non comme une prophétie, mais comme une incitation : qu’est-ce qui devrait changer — architecturalement et au niveau système — pour qu’une approche basée sur les LLM compte comme AGI au sens utile ?

Comment fonctionnent les LLM (sans le battage médiatique)

Les grands modèles de langage sont, au fond, des prédicteurs de texte extrêmement capables. Ils sont entraînés sur d’immenses collections de texte et apprennent des régularités statistiques : quelles séquences de mots suivent généralement d’autres, comment les idées sont couramment exprimées, et quels styles correspondent à quels contextes. Lorsque vous sollicitez un LLM, il ne « cherche pas » une réponse stockée ni ne consulte un modèle du monde comme beaucoup l’imaginent. Il génère le token suivant (un fragment de texte) le plus plausible compte tenu des tokens précédents, puis répète l’opération.

Entraînement : apprendre des motifs, pas des faits garantis

Pendant l’entraînement, le modèle voit une séquence de tokens et doit prédire le suivant. Au fil des exemples, il ajuste ses paramètres internes pour améliorer ses prédictions. Cela crée une capacité impressionnante à poursuivre du texte de manière cohérente — parce que la cohérence est fortement corrélée avec les motifs trouvés dans les données d’entraînement.

Augmenter les données et la puissance de calcul améliore souvent la fluidité et la polyvalence pour une raison simple : le modèle peut représenter davantage de motifs et s’y ajuster plus précisément. Avec suffisamment de capacité, il gère des constructions rares, suit des contextes plus longs et imite des styles d’écriture spécialisés. Rien de tout cela ne garantit une compréhension stable et ancrée de ce qu’il dit ; cela indique que le modèle est devenu très bon pour compléter des motifs.

Capacités « émergentes » : surprenantes, mais pas magiques

Certaines capacités semblent apparaître « soudainement » à des tailles de modèle plus grandes — explications multi-étapes, aide basique au codage, ou suivi d’instructions plus cohérent. Souvent, ce qui se passe est moins mystérieux : le modèle combine des motifs familiers de nouvelles manières, transfère une compétence observée dans de nombreuses formes adjacentes, ou devient suffisamment fiable pour qu’on la remarque.

Ces sauts peuvent sembler dramatiques, mais ils restent compatibles avec la prédiction du token suivant comme objectif sous-jacent.

Pourquoi la conversation nous induit en erreur

Les interfaces bavardes encouragent une interprétation humaine : la confiance sonore ressemble à de la connaissance ; un ton serviable ressemble à une intention ; une explication bien structurée ressemble à du raisonnement. Mais l’habileté conversationnelle n’est pas la même chose que la compréhension, l’intention ou le suivi de la vérité. Dans les déploiements pratiques, la position la plus sûre est de traiter la sortie d’un LLM comme un brouillon solide — pas comme une autorité.

Le texte n’est pas le monde : le déficit d’ancrage

Un modèle de langage peut produire des descriptions convaincantes de la réalité sans jamais être dans la réalité. Le texte est un enregistrement de l’expérience humaine — résumés, histoires, instructions, arguments — pas l’expérience elle-même. Quand un LLM prédit le mot suivant, il peut sembler « comprendre », mais il assemble peut-être simplement des motifs qui corrèlent avec la compréhension plutôt que la saisie causale et perceptuelle que les humains utilisent pour naviguer dans le monde.

Ce que signifie « ancrage »

L’ancrage est la connexion entre les symboles (mots, nombres, étiquettes) et quelque chose en dehors des symboles : perception, action et rétroaction. Les humains apprennent ce que signifie « chaud » en touchant une tasse chaude, en sursautant et en se rappelant. Nous raffermissons « lourd » en soulevant, en échouant, en ajustant la prise et en essayant à nouveau. Cette boucle — sentir, agir, observer les conséquences — ancre les concepts dans la réalité.

Un modèle purement textuel manque de cette boucle. Il peut réciter que « le verre se brise quand on le laisse tomber », mais il n’a pas la propriété de cette attente de façon à la mettre à jour quand les conditions changent (verre épais, sol en caoutchouc, faible hauteur). Il n’a généralement aucun canal direct pour vérifier ce qui est vrai maintenant, dans cette situation, sous ces contraintes.

Où « savoir des mots sur les choses » échoue

Les motifs purement linguistiques constituent un pauvre substitut à l’interaction ancrée dans plusieurs situations courantes. La causalité physique exige souvent de peser plusieurs facteurs interactifs plutôt que de matcher un mot-clé. Le raisonnement spatial peut échouer lorsque les instructions dépendent de rotations, de relations 3D cohérentes ou de l’application des mots à un environnement spécifique. Les contextes en temps réel — états d’inventaire, lectures de capteurs, état d’un patient — sont particulièrement risqués parce que la réponse « typique » d’hier peut être activement dangereuse. Et des situations vraiment nouvelles exposent la limite centrale : deviner ce qui sonne juste n’est pas la même chose qu’avoir raison.

Pourquoi cet écart est central pour l’AGI

L’AGI implique une compétence flexible à travers des environnements, pas seulement un commentaire éloquent à leur sujet. Sans ancrage, un LLM peut être un assistant puissant, mais il reste vulnérable à l’erreur confiante quand le monde exige vérification, expérimentation ou incertitude calibrée.

C’est aussi pourquoi de nombreux systèmes pratiques associent les LLM à des outils : bases de données, capteurs, simulateurs et vérifications humaines. Dans le travail appliqué — surtout les workflows de santé ou les systèmes d’entreprise sensibles à la sécurité — l’ancrage n’est pas philosophique ; c’est la différence entre un brouillon utile et une sortie sur laquelle on peut se fier en toute sécurité.

Fiabilité : hallucinations, fragilité et vérité

Les LLM peuvent sonner certains même lorsqu’ils ont tort. Ces échecs sont souvent appelés hallucinations : des sorties fluides, détaillées et affirmées avec confiance — mais non fondées sur des faits vérifiés. Le problème plus difficile est que le ton est fréquemment indiscernable d’une réponse correcte, donc l’inspection occasionnelle est une stratégie de fiabilité faible.

Pourquoi le texte fluide peut diverger de la vérité

Un LLM est entraîné pour prédire le token le plus probable suivant compte tenu du contexte. Cet objectif récompense la plausibilité — ce qui suit typiquement dans un texte similaire — plus que la recherche de la vérité. Si le modèle manque l’information nécessaire, il peut tout de même produire une meilleure estimation qui correspond au motif d’une réponse. Et même quand la bonne information existe quelque part dans les données d’entraînement, le modèle ne la récupère pas comme une base de données ; il échantillonne depuis une distribution de probabilité apprise. En conséquence, la justesse et l’objectif d’entraînement du modèle peuvent entrer en conflit.

Fragilité face à de petits changements

La fiabilité se rompt aussi de manière plus subtile. De petites modifications du prompt — formulation, ordre, contraintes supplémentaires — peuvent produire des conclusions significativement différentes. Des contraintes cachées, comme un long historique de chat ou des exigences ambiguës, peuvent orienter la sortie sans que l’utilisateur s’en aperçoive. Cette brittleness signale que vous n’interagissez pas avec un « moteur de raisonnement » stable, mais avec un générateur sensible dont le comportement dépend fortement du contexte.

Support décisionnel vs. prise de décision

À cause des hallucinations et de la fragilité du prompt, les LLM sont mieux traités comme support à la décision : rédaction, synthèse, remue-méninges, traduction du langage de domaine et proposition d’options. Le moment où vous les laissez prendre des décisions — approuver un changement de workflow médical, signer une déclaration de conformité, finaliser une logique financière — vous héritez d’un mode d’erreur à la fois subtil et persuasif.

En production, les équipes réduisent ce risque en ancrant les réponses dans des sources de confiance ou des données structurées, en exigeant des extraits de preuves dans le flux (pas seulement des affirmations confiantes), en enveloppant les étapes critiques de validations déterministes (schémas, règles, tests unitaires), et en maintenant une relecture humaine pour les actions à fort impact.

La fiabilité ne consiste pas à faire paraître les modèles « plus intelligents ». Il s’agit de concevoir des systèmes où paraître juste n’est jamais suffisant.

Le raisonnement n’est pas garanti par la fluidité

Une idée reçue persistante est que si un modèle peut paraître raisonner, il doit raisonner. Les LLM génèrent le token suivant qui convient le mieux aux motifs d’entraînement et au contexte immédiat. Ce processus peut imiter une logique pas à pas — parfois de façon impressionnante — sans garantir les contraintes que le raisonnement réel exige : cohérence, exhaustivité et vérification des erreurs.

Où le « raisonnement » des LLM semble réel

Les LLM réussissent souvent quand les bonnes réponses sont fortement corrélées avec des motifs linguistiques familiers : rédiger des explications, résumer des compromis, proposer des solutions plausibles, ou produire du code ressemblant à des implémentations courantes. Même lorsque le modèle ne prouve rien, il peut être un moteur heuristique efficace : il suggère des approches qu’un humain peut valider.

Où la fluidité se casse

Le problème apparaît quand la tâche exige une exactitude stricte sur le long terme plutôt qu’une narration plausible. La logique en plusieurs étapes peut s’effondrer lorsqu’une erreur précoce contamine tout le reste. Les problèmes de type preuve demandent des contraintes étanches, pas une prose persuasive. Les cas limites et conditions rares peuvent être sous-représentés dans le texte d’entraînement. Les conflits entre instructions, hypothèses et dépendances cachées peuvent tirer la complétion dans des directions incohérentes. Et les réponses en forme de bonne réponse peuvent sauter la vérification précisément parce qu’elles ont l’air convaincantes.

Pourquoi les outils et les couches de vérification comptent

L’image change quand le LLM est un composant à l’intérieur d’un système qui peut se vérifier. Des outils externes (calculateurs, interprètes, solveurs formels), la récupération de données autoritatives, et des vérifications structurées (tests unitaires, contrôles de cohérence, critiques inter-modèles, relecture humaine) peuvent transformer des suggestions fluides en résultats dignes de confiance.

Cela ne fait pas du modèle de base une AGI. Cela le rend un puissant interface pour générer des candidats — tandis que le reste du système fait le travail d’ancrage et de correction.

Agence et objectifs : les ingrédients manquants

Quand les gens imaginent l’AGI, ils pensent généralement à quelque chose avec de l’agence : il peut formuler des objectifs, s’y tenir dans le temps, planifier des actions pour les atteindre, observer les résultats et s’ajuster sur la base du retour. L’agence n’est pas juste « faire des tâches ». C’est un comportement autodirigé et persistant à travers des situations changeantes.

La plupart des LLM, par défaut, n’ont pas cela. Un modèle de chat génère le token suivant donné le prompt. Il peut parler de buts, plans et intentions avec une fluidité impressionnante, mais il ne veut intrinsèquement rien, et il ne poursuit pas d’objectifs une fois la conversation terminée. Sans boucle externe, il n’a pas de cible stable, pas de retour continu du monde, et aucun mécanisme pour décider quoi faire ensuite au-delà de répondre.

Complétion de chat vs. systèmes agentifs

Une configuration de complétion de chat est réactive : vous demandez, il répond. Une architecture agentive enveloppe le modèle d’un échafaudage qui fournit persistance et contrôle — files de tâches, outils (APIs), magasins de mémoire, planificateurs et évaluateurs qui vérifient les résultats. Dans ce montage, le système manifeste un comportement de type agence ; le modèle de langage n’en est qu’un composant.

Cette distinction compte en pratique. Si un « assistant IA » peut planifier des tâches, modifier des enregistrements ou déclencher des déploiements, la partie la plus risquée n’est pas la capacité rédactionnelle du modèle : ce sont les permissions et la boucle de décision qui l’entourent.

Pourquoi ajouter de l’agence augmente les enjeux

Donner au modèle un accès à des outils et de l’autonomie peut amplifier des modes d’échec ordinaires. Il peut poursuivre le mauvais objectif, sur-interpréter des instructions vagues, ou agir sur des hypothèses incorrectes. La solution n’est pas « un modèle plus intelligent » uniquement ; ce sont des garde-fous : spécifications d’objectifs claires, accès aux outils contraint, approbations pour les actions à fort impact, surveillance et évaluations serrées contre des résultats réels.

Mémoire, identité et continuité dans le temps

Les LLM peuvent sembler cohérents dans une seule conversation, mais cette « continuité » est souvent une illusion créée par une fenêtre de contexte à court terme. Dans cette fenêtre, le modèle peut référencer ce que vous venez de dire et garder un ton cohérent. En dehors — à travers des sessions plus longues, des jours ou des tâches réelles — il n’y a pas de soi durable inhérent, de croyances stables ou de compréhension persistante de vos objectifs.

Un court contexte n’est pas une mémoire à long terme

Ce que les gens appellent « mémoire » dans un LLM est généralement juste du texte encore visible dans le prompt. C’est plus proche d’une mémoire de travail que d’un registre de vie. Une fois que des détails antérieurs sortent de la fenêtre de contexte, le modèle ne s’en souvient pas ; il devine ce qui paraîtrait plausible.

L’intelligence générale, telle qu’imaginée, dépend de la continuité : apprendre de ses erreurs, accumuler des faits fiables, réviser des croyances et rester aligné sur des objectifs long terme même lorsque la conversation redémarre.

Dérive d’identité et de préférences

Sans état persistant, les LLM peuvent se contredire entre sessions : un outil qui « préférait » une approche aujourd’hui peut en recommander une autre demain, non parce qu’il a mis à jour sa vision du monde, mais parce qu’il échantillonne une complétion différente. Même dans une même session, de petits changements de prompt peuvent faire changer des priorités ou engendrer une nouvelle interprétation de ce que l’utilisateur voulait.

Cette fragilité importe pour des tâches réelles — collecte d’exigences, documentation médicale, projets logiciels sur plusieurs semaines — où cohérence et traçabilité sont aussi importantes que l’éloquence.

Ajouter de la mémoire avec récupération et état structuré (et ce que cela ne résout pas)

Pour compenser, les équipes ajoutent de la mémoire externe : systèmes de récupération, bases de données, profils utilisateur et états structurés réinjectés dans le prompt. Cela peut améliorer considérablement la continuité, et c’est courant en production.

Les couches typiques incluent des résumés de conversation, la récupération depuis des documents ou bases de connaissances, des profils de préférences utilisateur et permissions stockés en base, et un état de tâche structuré (décisions prises, questions ouvertes, contraintes). Mais ce sont des échafaudages autour du modèle, pas une identité interne auto-entretenue. La récupération peut ressortir la mauvaise information, les résumés peuvent effacer des nuances, et le modèle peut encore mal interpréter l’état stocké.

En pratique, un comportement fiable à long terme exige généralement une conception système soignée plus une relecture humaine.

Généralisation au-delà de la distribution d'entraînement

Si l’AGI existe un jour, elle devra faire plus que bien performer sur des motifs familiers. Elle devrait transférer ce qu’elle sait vers des domaines vraiment nouveaux, règles et objectifs, surtout quand la « bonne réponse » ne peut pas être trouvée en remixant ce qui ressemble à des exemples passés.

Généralisation vs. « ressembler suffisamment »

Beaucoup du succès des LLM s’explique mieux comme une interpolation puissante : produire des sorties cohérentes avec la structure statistique des données absorbées. Quand une tâche ressemble à des formats courants d’entraînement — explications, résumés, patterns de code, scripts de support client — les LLM peuvent paraître largement capables.

Mais l’interpolation n’est pas la généralisation au sens AGI. Un modèle peut exceller à compléter des motifs et échouer quand une tâche exige d’apprendre une nouvelle règle à la volée, de construire un modèle interne stable d’un environnement inconnu, ou de mettre à jour des croyances quand les observations contredisent l’hypothèse initiale.

Les échecs hors distribution ne sont pas des cas marginaux

Le travail réel crée constamment des situations hors distribution : nouvelles régulations, nouvelles contraintes produit, comportements utilisateurs inattendus, interfaces d’outils qui changent, jeux de données avec schémas nouveaux. Les LLM se dégradent souvent fortement quand la forme superficielle change ou quand le succès dépend de contraintes cachées plutôt que de la plausibilité textuelle.

Les problèmes apparaissent quand de nouvelles règles contredisent des conventions communes, quand les actions importent plus que la formulation (usage multi-étapes d’outils sous contraintes), quand des combinaisons de concepts rares surgissent, ou quand les instructions sont adversariales ou ambiguës — conditions où « avoir l’air juste » est facile et « avoir raison » est difficile.

Pourquoi les benchmarks peuvent flatter la capacité

Les benchmarks sont utiles, mais ils sont souvent optimisés pour la comparabilité, pas pour la surprise. Dès qu’un benchmark devient populaire, il façonne l’entraînement, les stratégies de prompt et les normes d’évaluation. Les scores montent tandis que la question réelle — « Gérera-t-il la prochaine chose qu’on n’a pas pensé à tester ? » — reste.

Pour les entreprises, cet écart est opérationnel : un système peut paraître « AGI-like » en démonstration interne et échouer quand un flux client diverge du jeu de tests. Les systèmes de production demandent typiquement des interfaces contraintes, des étapes de vérification et une escalade humaine pour les cas vraiment nouveaux.

Alignement et sécurité : la capacité ne suffit pas

Quand on affirme qu’un modèle très capable est « pratiquement AGI », on se concentre souvent sur ce qu’il peut faire en démo. L’alignement pose une question différente : le système poursuit-il de manière fiable l’intention de l’utilisateur dans les contraintes humaines, même lorsque le prompt est flou, adversarial ou moralement chargé ?

En pratique, l’alignement signifie faire correspondre objectifs (ce que l’utilisateur veut), valeurs (ce que la société permet) et limites (confidentialité, légalité, politiques de sécurité, règles opérationnelles) à travers des situations désordonnées.

Pourquoi le RLHF aide — et pourquoi il ne suffit pas

Le réglage par instruction et le RLHF (entraînement à partir de retours humains) peuvent rendre un modèle plus coopératif et moins toxique. Mais ils ne transforment pas le modèle en un raisonneur constamment principiel. Le système apprend toujours des motifs de réponses préférées, pas la compréhension profonde des valeurs humaines.

L’alignement n’est pas non plus un seul objectif. Il faut équilibrer des idéaux qui peuvent entrer en conflit : aide, honnêteté, sécurité, confidentialité et équité. Optimiser l’un peut mettre les autres en tension. Un modèle entraîné pour être « ultra utile » peut trop répondre et spéculer ; un modèle réglé pour une sécurité stricte peut refuser des demandes bénignes ; un modèle très prudent peut frustrer les utilisateurs et les pousser vers des contournements dangereux.

Pourquoi les revendications AGI doivent inclure la gouvernance

Si « AGI » signifie un système qui peut agir largement et avec compétence, la sécurité ne peut pas être une pensée après coup — plus la capacité augmente, plus le rayon d’impact des erreurs grandit. Les déploiements réels nécessitent de la gouvernance : politiques claires d’usage autorisé, journalisation et auditabilité, contrôle d’accès, relecture humaine pour les workflows sensibles et réponse aux incidents quand le système se comporte de façon inattendue.

Dans les produits à fort enjeu, l’alignement est moins une question de slogans qu’une discipline d’ingénierie : garde-fous, évaluations, supervision et responsabilité. La capacité attire l’attention ; la sécurité gagne la confiance.

Les systèmes basés sur des LLM peuvent-ils devenir AGI ? Que faudrait-il changer

La question clé n’est pas de savoir si un LLM peut être « amélioré » en AGI en lui ajoutant des outils. C’est de savoir si ajouter perception, mémoire et action comble les écarts fondamentaux : raisonnement fiable, compréhension ancrée et comportement cohérent à long terme.

Les outils aident — mais ils ne créent pas la compréhension par magie

Les systèmes hybrides paraissent déjà bien plus capables qu’un modèle de chat seul. Un LLM qui peut chercher, récupérer des documents, exécuter du code, appeler des APIs et vérifier son travail semblera « plus intelligent » sur beaucoup de tâches. En pratique, cette approche réduit les erreurs : la récupération peut ancrer les réponses dans des sources autoritatives, et l’exécution peut vérifier les calculs et la logique.

Mais l’utilisation d’outils change surtout la performance, pas la nature de la cognition centrale du modèle. Le LLM reste un générateur probabiliste de texte ; le système environnant doit le contraindre, le valider et décider quand lui faire confiance.

Ce qui rapprocherait significativement les systèmes de l’AGI

Si l’on évite les étiquettes et qu’on parle d’architectures, plusieurs changements importent plus que simplement agrandir les modèles :

- Modèles du monde ancrés : apprentissage lié à la perception et l’interaction, pas seulement au texte.

- Pipelines de raisonnement vérifiés : vérification systématique (exécution, méthodes formelles, preuves, tests de cohérence) par défaut, pas en option.

- Mémoire persistante avec gouvernance : connaissances durables et éditables et contexte utilisateur sans dérive incontrôlée ni risque de confidentialité.

- Boucles de planification et de contrôle : décomposition explicite des objectifs, surveillance et récupération en cas d’échec sur des horizons temporels longs.

- Entraînement pour la vérité et la calibration : systèmes capables de s’abstenir à bon escient et de signaler l’incertitude de façon fiable.

Pourquoi parler de capacités plutôt que d’« AGI » est plus sûr

« AGI » comprime de nombreuses propriétés — fiabilité, autonomie, transfert, robustesse, sécurité — en un seul mot. Décrire les systèmes en termes de ce qu’ils peuvent faire, sous quelles contraintes, et avec quels modes d’échec est plus honnête et plus utile pour l’ingénierie et la gestion des risques. Cela évite aussi le piège courant de confondre des démos impressionnantes avec une intelligence générale et dépendable.

Conclusions pratiques pour les entreprises qui construisent avec des LLM

Les LLM peuvent apporter une valeur réelle aujourd’hui — si vous les traitez comme des assistants probabilistes, pas comme des moteurs d’« compréhension » autonomes. Les déploiements solides commencent par un périmètre clair : quelles décisions le modèle peut influencer, ce qu’il ne doit jamais décider, et quelles preuves il doit fournir lorsqu’il produit une réponse.

Utilisez les LLM dans des rôles assistifs avec des garde-fous : protégez les entrées (filtres de confidentialité, templates de prompt, accès aux outils contraint) et contraignez les sorties (vérifications de format, ancrage dans des sources internes quand c’est possible, et expression explicite de l’incertitude quand nécessaire). Pour les workflows à fort impact — santé, finance, juridique, opérations critiques — exigez la relecture humaine et facilitez le travail du réviseur en affichant le contexte source pertinent à côté du brouillon du modèle.

L’audit est une pratique simple mais souvent négligée : échantillonnez les sorties régulièrement, étiquetez les échecs (hallucination, omission, suggestion dangereuse, violation de politique) et réinjectez ces étiquettes dans les mises à jour de prompt, l’optimisation de la récupération, les règles de routage et les tests d’évaluation.

Une règle de base concise :

- Utilisez les LLM pour des brouillons, résumés, extraction et Q&R sur des connaissances internes contrôlées.

- Ne vous fiez pas à eux comme source de vérité, ni pour des approbations irréversibles ou une automatisation ouverte sans contraintes.

Si vous transformez ces idées en logiciels de production — surtout dans des domaines régulés — des équipes comme SaaS Production (saasproduction.com) se concentrent souvent sur la conception système plutôt que sur le battage : intégration IA couplée à la relecture humaine, contrôles structurés et traçabilité pour que les gains de vitesse ne se fassent pas au détriment de la fiabilité.

Questions Fréquentes

Qu'est-ce qu'un LLM en termes pratiques ?

Un LLM (Large Language Model) est principalement un générateur probabiliste de texte entraîné à prédire le token suivant à partir de motifs trouvés dans de larges jeux de données. Il peut être extrêmement utile pour des tâches liées au langage (rédaction, résumé, traduction, assistance au codage), mais cela n’implique pas automatiquement : - une compréhension ancrée du monde réel - une capacité fiable à suivre la vérité - des objectifs durables ou un comportement autodirigé dans le temps

Que veulent dire les gens en parlant d'AGI ?

L’AGI est généralement entendu comme une intelligence largement capable d’apprendre et d’agir dans de nombreux environnements au niveau humain (ou au-delà), avec un raisonnement fiable et la capacité d’opérer dans le temps sans échafaudage humain constant. Concrètement, cela implique robustesse, acquisition de compétences, planification et performance cohérente dans des situations véritablement nouvelles — pas seulement des réponses fluides.

Pourquoi les débats sur « LLMs vs. AGI » sont-ils si confus ?

Parce que « généralisation » recouvre plusieurs sens. Un modèle peut généraliser à de nouvelles formulations de tâches familières (c’est souvent la force des LLM) tout en étant incapable de : - transférer des compétences vers de nouveaux domaines avec des règles différentes - s’adapter sur la base d’un retour réel - maintenir l’exactitude face à des cas limite et des changements de distribution

Qu'est-ce que le « gap d'ancrage » et pourquoi est-il important ?

L’ancrage est la connexion entre des symboles (mots) et la perception/action/retour du monde réel. Les humains apprennent des concepts par l’interaction (percevoir → agir → observer → mettre à jour). Un modèle purement textuel peut décrire le monde de manière convaincante sans avoir de moyen direct de vérifier ce qui est vrai *à l’instant* dans un environnement donné, ce qui constitue un écart central pour une autonomie fiable.

Pourquoi les LLM hallucinent-ils malgré un ton confiant ?

Les hallucinations surviennent parce que le modèle est optimisé pour la *continuité plausible*, pas pour la vérité garantie. Si l’information nécessaire n’apparaît pas dans le prompt (ou est ambiguë), le modèle peut produire une réponse en forme de vérité qui lit bien. Des mesures opérationnelles courantes incluent : - exiger des citations issues de sources internes approuvées - récupération depuis des magasins de données de confiance - validations déterministes (schémas, règles, tests unitaires) - relecture humaine pour les sorties à fort impact

Pourquoi les sorties des LLM sont-elles si sensibles au libellé du prompt ?

Le comportement d’un LLM peut varier fortement avec de petites modifications du prompt, l’ordre des contraintes, ou un contexte de conversation long. C’est le signe que vous interagissez avec un générateur sensible au contexte, et non avec un « moteur de raisonnement » stable. Pour réduire la fragilité : - utilisez des templates à structure constante - gardez les exigences explicites et testables - ajoutez des vérifications automatisées (format, contraintes, invariants) - évaluez avec un jeu de tests fixe avant déploiement

Les LLM raisonnent-ils réellement, ou imitent-ils seulement le raisonnement ?

Pas de manière fiable. Les LLM peuvent imiter un raisonnement pas à pas et proposer souvent de bonnes solutions candidates, mais ils peuvent sauter la vérification, dérailler en cours de chaîne, ou échouer sur des contraintes rares. Un schéma plus sûr consiste à : - laisser le LLM générer des options - vérifier avec des outils (exécution de code, calculateurs, solveurs) - imposer la correction via des tests et des revues - considérer la décision finale comme un résultat contrôlé du système, pas comme une complétion libre

Quelle est la différence entre un modèle de chat et un « agent » ?

Par défaut, la plupart des LLM sont réactifs : ils répondent aux prompts mais ne conservent pas d’objectifs ni n’agissent à moins qu’un système externe ne leur fournisse mémoire, outils et boucle de contrôle. Ajouter de l’agence (APIs, accès en écriture, actions automatisées) augmente le rayon d’impact des échecs ordinaires. Les protections pratiques incluent le principe du moindre privilège, des approbations pour les actions irréversibles, de la surveillance et des chemins d’escalade clairs.

Pourquoi les LLM n'ont-ils pas une vraie mémoire à long terme ni une identité cohérente ?

Ce que l’on appelle « mémoire » est souvent du texte encore présent dans la fenêtre de contexte. Une fois sorti de cette fenêtre, le modèle n’en garde pas le souvenir : il reconstruit ce qui paraît plausible. Pour obtenir de la continuité, les équipes ajoutent généralement un état externe : - état de tâche structuré (décisions, contraintes, questions ouvertes) - récupération depuis des documents vérifiés - préférences et permissions utilisateur stockées hors du modèle Même ainsi, il faut une gouvernance (quoi stocker, qui y accède, comment corriger) et des contrôles contre les erreurs de récupération ou d’interprétation.

Comment les entreprises devraient-elles utiliser les LLM en production de façon sûre (surtout dans les secteurs régulés) ?

Concentrez-vous sur les capacités et les modes d’échec, puis concevez le système en conséquence : - Utilisez les LLM pour des brouillons, résumés, extraction et Q&R sur des connaissances internes contrôlées. - Ne les considérez pas comme source de vérité pour des approbations médicales, juridiques, financières ou de conformité. - Dans la santé et les flux liés aux EMR/EHR, exigez traçabilité, journaux d’audit et relecture humaine. - Ajoutez des garde-fous déterministes (schémas, règles, tests unitaires/intégration) et des audits réguliers des sorties. L’objectif est la vitesse *avec* fiabilité : traitez le modèle comme un composant intégré à un flux vérifié, pas comme une autorité autonome.