Por que LLMs não são AGI: Limites, Mitos e Próximos Passos

Modelos de linguagem parecem inteligentes, mas carecem de objetivos, grounding e raciocínio confiável. Explore limites-chave, mitos e caminhos realistas a seguir.

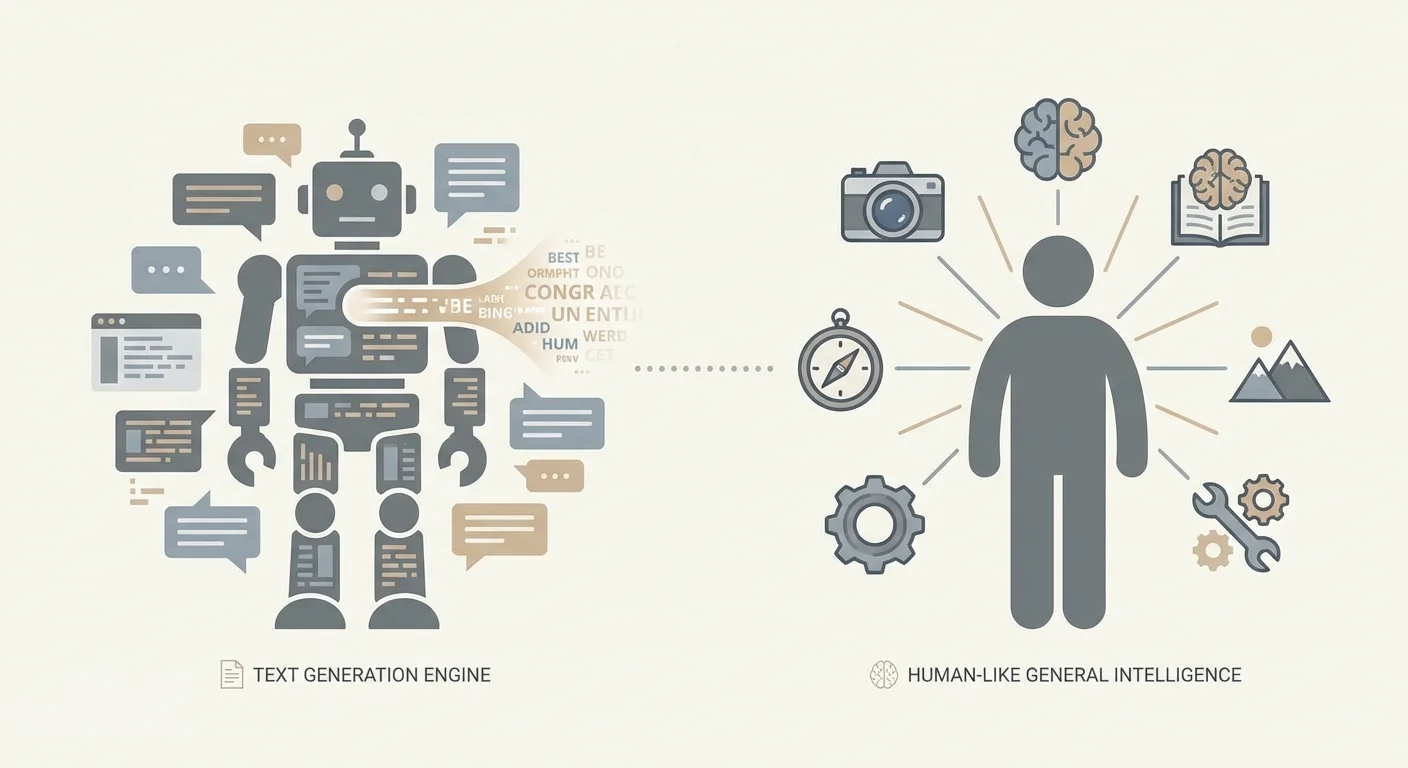

LLM vs. AGI: O que entendemos pelos termos

Grande parte do debate “LLMs são (ou não são) AGI” é, na verdade, um problema de terminologia. Pessoas usam as mesmas palavras para significar coisas diferentes e acabam falando uma com a outra sem se entender. Antes de debater o que os sistemas de hoje conseguem, ajuda definir os termos.

Um LLM (Large Language Model) é um modelo treinado para prever e gerar texto (e às vezes outras modalidades) a partir de padrões em grandes conjuntos de dados. Pode ser notavelmente capaz em explicar, resumir, traduzir, programar e conversar — porque essas tarefas se alinham bem com predição de linguagem. Essa capacidade, por si só, não implica entendimento estável do mundo, metas duradouras ou habilidade de operar de forma independente.

IA estreita (Narrow AI) descreve sistemas que atuam bem em domínios específicos ou famílias de tarefas—filtros de spam, classificadores de imagens médicas, otimização de rotas e (provavelmente) a maioria das implantações atuais de LLMs. Sistemas estreitos podem ser extremamente poderosos e economicamente importantes sem serem “gerais”.

AGI (Inteligência Artificial Geral) é um termo mais difuso, mas a ideia prática é um agente que pode aprender e atuar em uma ampla variedade de tarefas e ambientes em nível humano (ou além), com raciocínio confiável, habilidade de adquirir novas competências e competência para agir ao longo do tempo sem escorada humana constante.

Até mesmo “generalização” pode significar coisas diferentes. Às vezes significa desempenhar bem em uma nova formulação de tarefas familiares; às vezes significa transferir habilidades entre domínios; outras vezes significa adaptar-se a situações genuinamente novas com orientação mínima. Isso não é equivalente. LLMs podem se destacar no primeiro e ainda ter dificuldades no último.

Esse debate importa porque decisões reais são tomadas com base nele. Empresas podem automatizar em excesso fluxos críticos, reguladores podem direcionar políticas equivocadas e equipes podem subinvestir em controles de segurança. Em contextos de alto risco — como desenvolvimento de software e fluxos de trabalho em saúde (incluindo contextos EMR/EHR) — a saída confiante de um LLM pode parecer competência até falhar em um caso-limite onde correção e rastreabilidade são inegociáveis.

Este artigo não sustenta que LLMs sejam inúteis ou “apenas autocomplete”. Argumenta que fluência não é o mesmo que inteligência geral, e que os LLMs de hoje têm limites estruturais que os deixam aquém da AGI.

Por fim, “nunca” é uma afirmação forte. Trate-a aqui não como profecia, mas como um estímulo: o que precisaria mudar — arquiteturalmente e em nível de sistema — para que uma abordagem baseada em LLMs conte como AGI em algum sentido significativo?

Como os LLMs funcionam (sem o hype)

Grandes modelos de linguagem são, em sua essência, preditores de texto extremamente capazes. São treinados em vastas coleções de texto e aprendem regularidades estatísticas: quais sequências de palavras tendem a seguir outras, como ideias são comumente expressas e quais estilos combinam com quais contextos. Quando você dá um prompt a um LLM, ele não “consulta” uma resposta armazenada nem consulta um modelo de mundo da maneira que muitos imaginam. Gera o próximo token (um pedaço de texto) mais plausível dado os tokens até então, e repete esse passo.

Treinamento: aprendendo padrões, não fatos com garantias

Durante o treinamento, o modelo vê uma sequência de tokens e é solicitado a prever o próximo. Ao ver muitos exemplos, ajusta parâmetros internos para melhorar suas previsões. Isso cria uma habilidade impressionante de continuar textos de forma coerente — porque coerência está fortemente correlacionada com os padrões no conjunto de treinamento.

Aumentar dados e computação frequentemente melhora fluência e versatilidade por uma razão simples: o modelo pode representar mais padrões e ajustá-los com maior precisão. Com capacidade suficiente, lida com construções mais raras, segue contextos mais longos e imita estilos de escrita especializados. Nada disso garante um entendimento estável e fundamentado do que está sendo dito; indica que o modelo ficou muito bom em completar padrões.

Habilidades “emergentes”: surpreendentes, mas não mágicas

Algumas capacidades parecem surgir “de repente” em modelos maiores — explicações em vários passos, ajuda básica com código ou seguir instruções com mais consistência. Frequentemente, o que acontece é menos misterioso: o modelo está combinando padrões familiares de novas maneiras, transferindo uma habilidade vista em muitas formas adjacentes ou ficando confiável o bastante para que os usuários percebam.

Esses saltos podem parecer dramáticos, mas permanecem consistentes com a predição do próximo token como objetivo subjacente.

Por que a conversa nos engana

Interfaces de conversa incentivam uma interpretação humana: confiança soa como conhecimento; um tom útil soa como intenção; uma explicação bem estruturada soa como raciocínio. Mas habilidade conversacional não é a mesma coisa que compreensão, metas ou rastreamento da verdade. Em implantações práticas, a postura mais segura é tratar a saída do LLM como um rascunho forte — não como autoridade.

Texto não é o mundo: a lacuna do grounding

Um modelo de linguagem pode produzir descrições convincentes da realidade sem jamais estar no mundo. Texto é um registro da experiência humana — resumos, histórias, instruções, argumentos — não a experiência em si. Quando um LLM prevê a próxima palavra, pode soar como se “entendesse”, mas pode simplesmente estar montando padrões que correlacionam com entendimento, em vez da apreensão causal e perceptual que os humanos usam para navegar o mundo.

O que significa “grounding”

Grounding é a conexão entre símbolos (palavras, números, rótulos) e algo fora dos símbolos: percepção, ação e feedback. Humanos aprendem o que “quente” significa tocando uma caneca morna, retraindo a mão e lembrando. Refinamos “pesado” ao levantar, falhar, ajustar a pegada e tentar de novo. Esse ciclo — perceber, agir, observar consequências — ancora conceitos à realidade.

Um modelo puramente textual carece desse ciclo. Pode recitar que “o vidro quebra quando é deixado cair”, mas não possuir a expectativa de forma que seja atualizável quando as condições mudam (vidro grosso, piso de borracha, pouca altura). Geralmente não tem canal direto para verificar o que é verdade agora, nesta situação, sob essas restrições.

Onde “saber palavras sobre coisas” falha

Padrões apenas textuais tornam-se substitutos pobres para interação fundamentada em várias situações comuns. Causalidade física frequentemente exige avaliar múltiplos fatores interagentes em vez de combinar uma única palavra-chave. Raciocínio espacial pode falhar quando instruções dependem de rotações, relações 3D consistentes ou mapear palavras a um ambiente específico. Contextos em tempo real — estados de inventário, leituras de sensores, status de pacientes — são especialmente arriscados porque a resposta “típica” de ontem pode ser ativamente perigosa. E situações genuinamente novas expõem a limitação central: adivinhar o que soa certo não é o mesmo que estar certo.

Por que essa lacuna é central para AGI

AGI implica competência flexível através de ambientes, não apenas comentários eloquentes sobre eles. Sem grounding, um LLM pode ser um assistente poderoso, mas permanece vulnerável a erros confiantes quando o mundo exige verificação, experimentação ou incerteza calibrada.

É também por isso que muitos sistemas práticos emparelham LLMs com ferramentas: bancos de dados, sensores, simuladores e checagens humanas. No trabalho aplicado — especialmente em saúde ou sistemas empresariais sensíveis à segurança — grounding não é filosófico; é a diferença entre um rascunho útil e uma saída em que você pode confiar com segurança.

Confiabilidade: alucinações, fragilidade e verdade

LLMs podem soar certos mesmo quando estão errados. Essas falhas são frequentemente chamadas de alucinações: saídas que são fluidas, detalhadas e afirmadas com confiança — mas não fundamentadas em fatos verificados. A parte mais difícil é que o tom frequentemente é indistinguível de uma resposta correta, então “olhar por cima” de forma informal é uma estratégia fraca de confiabilidade.

Por que texto fluente pode se afastar da verdade

Um LLM é treinado para prever o token mais provável seguinte dado seu contexto. Esse objetivo recompensa plausibilidade — o que tipicamente segue em textos semelhantes — mais do que busca da verdade. Se o modelo não tem a informação necessária, ele pode ainda assim produzir uma melhor suposição que combine com o padrão de uma resposta. E mesmo quando a informação correta existe em algum lugar nos dados de treinamento, o modelo não a está recuperando como um banco de dados; está amostrando de uma distribuição de probabilidade aprendida. Como resultado, correção e o objetivo central do treinamento podem conflitar.

Fragilidade a pequenas mudanças

A confiabilidade também se quebra de maneiras mais sutis. Pequenas edições de prompt — redação, ordem, restrições extras — podem produzir conclusões significativamente diferentes. Restrições ocultas, como histórico de chat longo ou requisitos ambíguos, podem guiar a saída sem que o usuário perceba. Essa fragilidade é sinal de que você não está interagindo com um “motor de raciocínio” estável, mas com um gerador sensível cujo comportamento depende fortemente do contexto.

Apoio à decisão vs. tomada de decisão

Por causa de alucinações e fragilidade de prompt, LLMs são melhores tratados como suporte à decisão: rascunhando, resumindo, brainstorming, traduzindo linguagem de domínio e propondo opções. No momento em que você os deixa tomar decisões — aprovar uma mudança em um fluxo de trabalho médico, assinar uma declaração de conformidade ou finalizar lógica financeira — você herda um modo de erro que pode ser tanto sutil quanto persuasivo.

Em ambientes de produção, equipes reduzem esse risco fundindo respostas em fontes confiáveis ou dados estruturados, exigindo trechos de evidência dentro do fluxo de trabalho (não só afirmações confiantes), envolvendo etapas críticas em validações determinísticas (esquemas, regras, testes unitários) e mantendo revisão Humano-no-Laço para ações de alto impacto.

Confiabilidade não é sobre fazer modelos “soarem mais inteligentes.” É sobre projetar sistemas onde soar certo nunca é suficiente.

Raciocínio não é garantido pela fluência

Uma concepção errada persistente é que, se um modelo consegue soar como se estivesse raciocinando, então ele deve estar raciocinando. LLMs geram o próximo token que melhor se encaixa nos padrões de treinamento e no contexto imediato. Esse processo pode imitar lógica passo a passo — às vezes de forma impressionante — sem impor de forma confiável as restrições que o raciocínio real exige: consistência, completude e verificação de erros.

Onde o “raciocínio” dos LLMs parece real

LLMs frequentemente se saem bem quando boas respostas estão fortemente correlacionadas com padrões linguísticos familiares: redigir explicações, resumir trade-offs, propor soluções plausíveis ou gerar código que se parece com implementações comuns. Mesmo quando o modelo não está provando nada, pode ser um motor heurístico eficaz: sugere abordagens que um humano pode validar.

Onde a fluência falha

O problema aparece quando a tarefa exige correção estrita em longo prazo, não apenas narração plausível. Lógica em múltiplos passos pode colapsar quando um erro inicial contamina todo o restante. Problemas que exigem provas demandam restrições herméticas, não prosa persuasiva. Casos-limite e condições raras podem estar sub-representados no texto de treinamento. Conflitos entre instruções, suposições e dependências ocultas podem puxar a conclusão em direções inconsistentes. E respostas com aparência de resposta podem pular a verificação justamente porque soam bem.

Por que ferramentas e camadas de verificação importam

O quadro muda quando o LLM é um componente dentro de um sistema que pode checar a si mesmo. Ferramentas externas (calculadoras, interpretadores, solvedores formais), recuperação de dados autoritativos e verificação estruturada (testes unitários, checagens de consistência, crítica entre modelos, revisão Humano-no-Laço) podem transformar sugestões fluidas em resultados confiáveis.

Isso não transforma o modelo base em AGI. Torna-o uma interface poderosa para gerar candidatos — enquanto o resto do sistema faz o trabalho de grounding e correção.

Agência e objetivos: os ingredientes ausentes

Quando as pessoas imaginam AGI, costumam visualizar algo com agência: capaz de formar objetivos, mantê-los ao longo do tempo, planejar ações para alcançá-los, observar o que aconteceu e ajustar com base no feedback. Agência não é apenas “fazer tarefas.” É comportamento persistente e autodirigido em situações mutantes.

A maioria dos LLMs, por padrão, não tem isso. Um modelo de chat gera o próximo token dado o prompt. Pode falar sobre metas, planos e intenções com fluência impressionante, mas não quer intrinsecamente nada, e não continua perseguindo objetivos quando a conversa termina. Sem um loop externo, não tem alvo estável, feedback do mundo contínuo ou mecanismo para decidir o que fazer além de responder.

Complemento de chat vs. sistemas agentes

Uma configuração de chat completion é reativa: você pergunta, ele responde. Uma arquitetura agentic envolve o modelo em uma estrutura que fornece persistência e controle — filas de tarefas, ferramentas (APIs), repositórios de memória, planejadores e avaliadores que checam resultados. Nessa configuração, o sistema exibe comportamento parecido com agência; o modelo de linguagem é um componente.

Essa distinção importa na prática. Se um “assistente de IA” pode agendar trabalhos, modificar registros ou acionar deploys, a parte mais arriscada não é a habilidade de escrita do modelo — são as permissões e o laço de decisão ao seu redor.

Por que adicionar agência aumenta os riscos

Dar a um modelo acesso a ferramentas e autonomia pode amplificar modos de falha ordinários. Pode perseguir o objetivo errado, interpretar excessivamente instruções vagas ou agir com base em suposições incorretas. A correção não é “um modelo mais inteligente” sozinho; são salvaguardas: especificações claras de metas, acesso a ferramentas restrito, aprovações para ações de alto impacto, monitoramento e avaliação rígida contra resultados reais.

Memória, identidade e continuidade ao longo do tempo

LLMs podem soar consistentes dentro de uma única conversa, mas essa “continuidade” costuma ser uma ilusão criada por uma janela de contexto de curto prazo. Dentro dessa janela, o modelo pode referenciar o que você acabou de dizer e manter um tom coerente. Fora dela — ao longo de sessões mais longas, dias ou tarefas do mundo real — não existe, inerentemente, um eu durável, crenças estáveis ou compreensão persistente de seus objetivos.

Contexto curto não é memória de longo prazo

O que as pessoas chamam de “memória” em um LLM é geralmente apenas o texto que ainda está visível no prompt. É mais parecido com memória de trabalho do que com um registro de vida. Quando detalhes anteriores saem da janela de contexto, o modelo não os lembra; ele adivinha o que seria plausível.

Inteligência geral, como imaginada por muitos, depende de continuidade: aprender com erros, acumular fatos confiáveis, revisar crenças e manter alinhamento com objetivos de longo prazo mesmo quando a conversa é reiniciada.

Deriva de identidade e preferência

Sem estado persistente, LLMs podem se contradizer entre sessões: uma ferramenta que “prefere” uma abordagem hoje pode recomendar o oposto amanhã, não porque tenha atualizado sua visão de mundo, mas porque está amostrando uma conclusão diferente. Mesmo dentro da mesma sessão, pequenas mudanças no prompt podem produzir prioridades mutantes ou uma nova interpretação do que o usuário quis dizer.

Essa fragilidade importa para tarefas reais — levantamento de requisitos, documentação médica, projetos de software de várias semanas — onde consistência e rastreabilidade são tão importantes quanto eloquência.

Adicionar memória com recuperação e estado estruturado (e o que isso não resolve)

Para compensar, equipes conectam memória externa: sistemas de recuperação, bancos de dados, perfis de usuário e estado estruturado que é reinjetado no prompt. Isso pode melhorar dramaticamente a continuidade e é comum em sistemas de produção.

Camadas típicas incluem sumários de conversação, recuperação de documentos ou bases de conhecimento, perfis de preferência do usuário e permissões armazenadas em banco de dados, e estado de tarefa estruturado (decisões tomadas, perguntas em aberto, restrições). Mas isso são andaimes em torno do modelo, não uma identidade interna que se mantém sozinha. A recuperação pode trazer o dado errado, sumários podem apagar nuances e o modelo ainda pode interpretar mal o estado armazenado.

Na prática, comportamento confiável de longo prazo geralmente exige design de sistema cuidadoso mais revisão Humano-no-Laço.

Generalização além da distribuição de treinamento

Se AGI algum dia existir, ela terá de fazer mais do que ter bom desempenho em padrões familiares. Deve transferir o que sabe para domínios genuinamente novos, regras e objetivos, especialmente quando a “resposta certa” não pode ser encontrada apenas remixando exemplos passados.

Generalização vs. “parecer semelhante o bastante”

Muito do sucesso dos LLMs é melhor descrito como interpolação poderosa: produzir saídas consistentes com a estrutura estatística dos dados que absorveram. Quando uma tarefa se assemelha a formatos comuns vistos em treinamento — explicações, resumos, padrões de código, roteiros de suporte ao cliente — os LLMs podem parecer amplamente capazes.

Mas interpolação não é o mesmo que generalização no sentido de AGI. Um modelo pode ser excelente em completar padrões e ainda falhar quando uma tarefa exige aprender uma regra nova em tempo real, construir um modelo interno estável de um ambiente desconhecido ou atualizar crenças quando observações contradizem a suposição inicial.

Falhas fora da distribuição não são casos-limite

O trabalho real cria constantemente situações fora da distribuição: novas regulamentações, novas restrições de produto, comportamento inesperado de usuários, interfaces de ferramentas que mudam, conjuntos de dados com esquemas inéditos. LLMs frequentemente se degradam abruptamente quando a forma superficial muda ou quando o sucesso depende de restrições ocultas mais do que de plausibilidade textual.

Os problemas tendem a aparecer quando novas regras contradizem convenções comuns, quando ações importam mais do que redação (uso de ferramentas em vários passos sob restrições), quando combinações raras de conceitos aparecem ou quando instruções são adversariais ou ambíguas — condições onde “soar certo” é fácil e estar certo é difícil.

Por que benchmarks podem embelezar capacidades

Benchmarks são úteis, mas frequentemente otimizados para comparabilidade, não surpresa. Uma vez que um benchmark se torna popular, ele molda treinamento, estratégias de prompt e normas de avaliação. As pontuações sobem enquanto a questão real — “isso lidará com a próxima coisa que não pensamos em testar?” — permanece.

Para empresas, essa lacuna é operacional: um sistema pode parecer “AGI-ish” em demos internas e ainda falhar quando um fluxo de cliente desvia do seu conjunto de testes. Sistemas de produção tipicamente precisam de interfaces restritas, etapas de verificação e escalonamento humano para casos genuinamente novos.

Alinhamento e segurança: capacidade não é suficiente

Quando pessoas argumentam que um modelo altamente capaz é “basicamente AGI”, costumam focar no que ele pode fazer em uma demo. Alinhamento faz uma pergunta diferente: o sistema busca de forma confiável a intenção do usuário dentro de limites humanos, mesmo quando o prompt é confuso, adversarial ou moralmente carregado?

Na prática, alinhamento significa casar metas (o que o usuário quer), valores (o que a sociedade permite) e limites (privacidade, legalidade, políticas de segurança, regras operacionais) através de situações desordenadas.

Por que RLHF ajuda — e por que não resolve tudo

Tuning por instrução e RLHF (treinamento com feedback humano) podem tornar um modelo mais cooperativo e menos tóxico. Mas não transformam o modelo em um raciocinador consistentemente principiado. O sistema ainda aprende padrões de respostas preferidas, não a compreensão dos valores humanos.

Alinhamento também não é um único objetivo. Você está equilibrando ideais que podem conflitar: utilidade, honestidade, segurança, privacidade e justiça. Otimizar um frequentemente pressiona os outros. Um modelo treinado para ser maximamente “útil” pode responder demais e especular; um modelo sintonizado para extrema segurança pode recusar pedidos benignos; um modelo muito cauteloso pode frustrar usuários e empurrá-los para soluções alternativas inseguras.

Por que declarações de AGI devem incluir governança

Se “AGI” significa um sistema que pode agir de forma ampla e competente, segurança não pode ser um pensamento tardio — maior capacidade aumenta a área de impacto de erros. Implantações reais precisam de governança: políticas claras de uso permitido, registro e auditabilidade, controle de acesso, revisão Humano-no-Laço para fluxos sensíveis e resposta a incidentes quando o sistema se comporta de forma inesperada.

Em produtos de alto risco, alinhamento é menos sobre slogans e mais sobre disciplina de engenharia: guardrails, avaliações, monitoramento e responsabilidade. Capacidade chama atenção; segurança conquista confiança.

Sistemas baseados em LLM podem se tornar AGI? O que teria de mudar

A questão-chave não é se um LLM pode ser “atualizado” para AGI apenas acoplando ferramentas. É se adicionar percepção, memória e ação fecha as lacunas fundamentais: raciocínio confiável, entendimento fundamentado e comportamento coerente em horizonte longo.

Ferramentas ajudam — mas não criam compreensão magicamente

Sistemas híbridos já parecem muito mais capazes do que um modelo só de chat. Um LLM que pode buscar, recuperar documentos, executar código, chamar APIs e checar seu próprio trabalho parecerá “mais inteligente” em muitas tarefas. Na prática, essa abordagem reduz erros: recuperação ancorando respostas em fontes autorizadas e execução verificando matemática e lógica.

Mas uso de ferramentas muda principalmente o desempenho, não a natureza da cognição central do modelo. O LLM continua sendo um gerador probabilístico de texto; o sistema ao redor deve constrangê‑lo, validá‑lo e decidir quando confiá‑lo.

O que aproximaria sistemas de AGI de modo significativo

Se evitarmos rótulos e falarmos de arquiteturas, várias mudanças importam mais do que simplesmente aumentar modelos:

- Modelos de mundo fundamentados: aprendizado atrelado à percepção e interação, não apenas ao texto.

- Pipelines de raciocínio verificados: checagens sistemáticas (execução, métodos formais, provas, testes de consistência) como padrão, não opção.

- Memória persistente com governança: conhecimento durável e editável e contexto específico do usuário sem deriva descontrolada ou risco de privacidade.

- Planejamento e laços de controle: decomposição explícita de metas, monitoramento e recuperação de falhas ao longo de horizontes temporais longos.

- Treinamento para verdade e calibração: sistemas que possam abster-se adequadamente e sinalizar incerteza de forma confiável.

Por que linguagem centrada em capacidade é mais segura que “AGI”

“AGI” comprime muitas propriedades — confiabilidade, autonomia, transferência, robustez, segurança — em uma única palavra. Descrever sistemas em termos do que eles podem fazer, sob quais restrições e com quais modos de falha é mais honesto e mais útil para engenharia e gestão de riscos. Também evita a armadilha comum de confundir demos impressionantes com inteligência geral e confiável.

Lições práticas para empresas que constroem com LLMs

LLMs podem gerar valor real hoje — se você os tratar como assistentes probabilísticos, não como motores autônomos de “entendimento”. Implantações sólidas começam com escopo claro: quais decisões o modelo pode influenciar, o que ele nunca deve decidir e que evidência deve apresentar ao produzir uma resposta.

Use LLMs em papéis assistivos com guardrails: proteja inputs (filtros de privacidade, templates de prompt, acesso controlado a ferramentas) e restrinja outputs (checagens de formato, ancoragem em fontes internas quando possível e indicação explícita de incerteza quando necessário). Para fluxos de alto impacto — saúde, finanças, jurídico, operações críticas de segurança — exija revisão Humano-no-Laço e facilite o trabalho do revisor, exibindo o contexto-fonte relevante ao lado do rascunho do modelo.

Auditoria é uma prática simples mas frequentemente negligenciada: amostre saídas regularmente, rotule falhas (alucinação, omissão, sugestão insegura, violação de política) e alimente esses rótulos em atualizações de prompt, ajuste de recuperação, regras de roteamento e testes de avaliação.

Uma regra prática concisa:

- Use LLMs para rascunhos, resumos, extração e Perguntas e Respostas sobre conhecimento interno controlado.

- Não dependa deles como fonte de verdade, nem para aprovações irreversíveis e automação aberta sem restrições.

Se você está transformando essas ideias em software de produção — especialmente em domínios regulados — equipes como a SaaS Production (saasproduction.com) frequentemente focam em design de sistema ao invés de hype: integração de IA pareada com revisão Humano-no-Laço, checagens estruturadas e rastreabilidade para que ganhos de velocidade não custem confiabilidade.

Perguntas Frequentes

O que é um LLM na prática?

Um LLM (Large Language Model) é, no fundo, um gerador probabilístico de texto treinado para prever o próximo token a partir de padrões em grandes conjuntos de dados. Pode ser extremamente útil em trabalhos moldados por linguagem (rascunhos, resumos, traduções, assistência com código), mas isso não garante automaticamente: - entendimento fundamentado do mundo real - rastreamento confiável da verdade - metas duráveis ou comportamento autodirigido ao longo do tempo

O que as pessoas normalmente querem dizer por AGI?

AGI costuma ser entendido como uma inteligência amplamente capaz que pode aprender e atuar em muitos ambientes em nível humano (ou superior), com raciocínio confiável e capacidade de operar ao longo do tempo sem depender constantemente de suporte humano. Na prática, isso implica robustez, aquisição de habilidades, planejamento e desempenho consistente em situações genuinamente novas — não apenas respostas fluentes.

Por que os debates sobre “LLMs vs. AGI” ficam tão confusos?

Porque “generalização” é usado para significar coisas diferentes. Um modelo pode generalizar para novas formulações de tarefas familiares (um ponto forte dos LLMs) e ainda assim falhar em: - transferir habilidades para novos domínios com regras novas - adaptar-se com base em feedback do mundo real - manter correção em casos-limite e sob mudanças de distribuição

O que é a “lacuna de grounding” e por que ela importa?

Grounding é a conexão entre símbolos (palavras) e percepção/ação/feedback no mundo real. Humanos aprendem conceitos através da interação (sentir → agir → observar → atualizar). Um modelo somente de texto pode descrever o mundo de forma convincente sem ter um modo direto de verificar o que é verdade *agora* em um ambiente específico, o que é uma lacuna central para autonomia confiável.

Por que os LLMs alucinam mesmo quando soam confiantes?

As alucinações ocorrem porque o modelo é otimizado para *continuação plausível*, não para verdade garantida. Se a informação necessária não está presente no prompt (ou é ambígua), o modelo ainda pode gerar uma resposta em forma de resposta que parece correta. Mitigações operacionais incluem com frequência: - exigir citações de fontes internas aprovadas (dentro do fluxo de trabalho) - recuperação (retrieval) de armazenamentos de dados confiáveis - validação determinística (esquemas, regras, testes unitários) - revisão Humano-no-Laço para saídas de alto impacto

Por que as saídas dos LLMs são tão sensíveis à forma do prompt?

O comportamento do LLM pode mudar significativamente com pequenas edições no prompt, diferente ordenação de restrições ou contexto oculto em um chat longo. Isso indica que você está lidando com um gerador sensível ao contexto, não com um “motor de raciocínio” estável. Para reduzir fragilidade: - use modelos de prompt (templates) com estrutura consistente - mantenha requisitos explícitos e testáveis - adicione verificações automatizadas (formato, restrições, invariantes) - avalie com um conjunto de testes fixo antes de implantar mudanças

LLMs realmente raciocinam ou apenas imitam raciocínio?

Não de forma confiável. LLMs podem imitar raciocínios passo a passo e frequentemente propõem boas soluções candidatas, mas podem pular verificações, derivar erros no meio da cadeia ou falhar em restrições raras. Um padrão mais seguro é: - permitir que o LLM gere opções - verificar com ferramentas (código executado, calculadoras, solvedores) - impor correção com testes e revisões - tratar a decisão final como um resultado de sistema controlado, não como um texto livre

Qual é a diferença entre um modelo de chat e um “agente”?

Por padrão, a maioria dos LLMs é reativa: responde a prompts, mas não preserva metas nem age a menos que um sistema envolvente forneça memória, ferramentas e um laço de controle. Adicionar agência (APIs, acesso de escrita, ações automatizadas) aumenta a zona de impacto das falhas comuns. Salvaguardas práticas incluem permissões no princípio do menor privilégio, aprovações para ações irreversíveis, monitoramento e caminhos claros de escalonamento.

Por que os LLMs não têm memória de longo prazo real ou identidade consistente?

O que costumam chamar de “memória” é muitas vezes apenas o texto da conversa ainda visível na janela de contexto. Quando isso sai da janela, o modelo não lembra — ele faz uma estimativa plausível. Para conseguir continuidade, equipes normalmente adicionam estado externo: - estado de tarefa estruturado (decisões, restrições, questões em aberto) - recuperação de documentos verificados - permissões e preferências de usuário armazenadas fora do modelo Mesmo assim, é preciso governança (o que pode ser armazenado, quem acessa, como corrigir) e verificações contra recuperação incorreta ou interpretação errada.

Como as empresas devem usar LLMs com segurança em produção (especialmente em domínios regulados)?

Concentre-se em capacidades e modos de falha, e então projete o sistema em torno deles: - Use LLMs para rascunhos, resumos, extração e Perguntas e Respostas sobre conhecimento interno controlado. - Não os use como fonte de verdade para aprovações médicas, legais, financeiras ou de conformidade. - Em saúde e fluxos próximos a EMR/EHR, exija rastreabilidade, logs de auditoria e revisão Humano-no-Laço. - Adicione salvaguardas determinísticas (esquemas, regras, testes unitários/integrados) e auditoria rotineira das saídas. O objetivo é velocidade com confiabilidade: trate o modelo como um componente dentro de um fluxo de trabalho verificado, não como uma autoridade autônoma.