Почему LLM не являются AGI: ограничения, мифы и что дальше

Большие языковые модели кажутся умными, но им не хватает целей, привязки к реальности и надёжного рассуждения. Изучите ключевые ограничения, распространённые мифы и реалистичные пути развития.

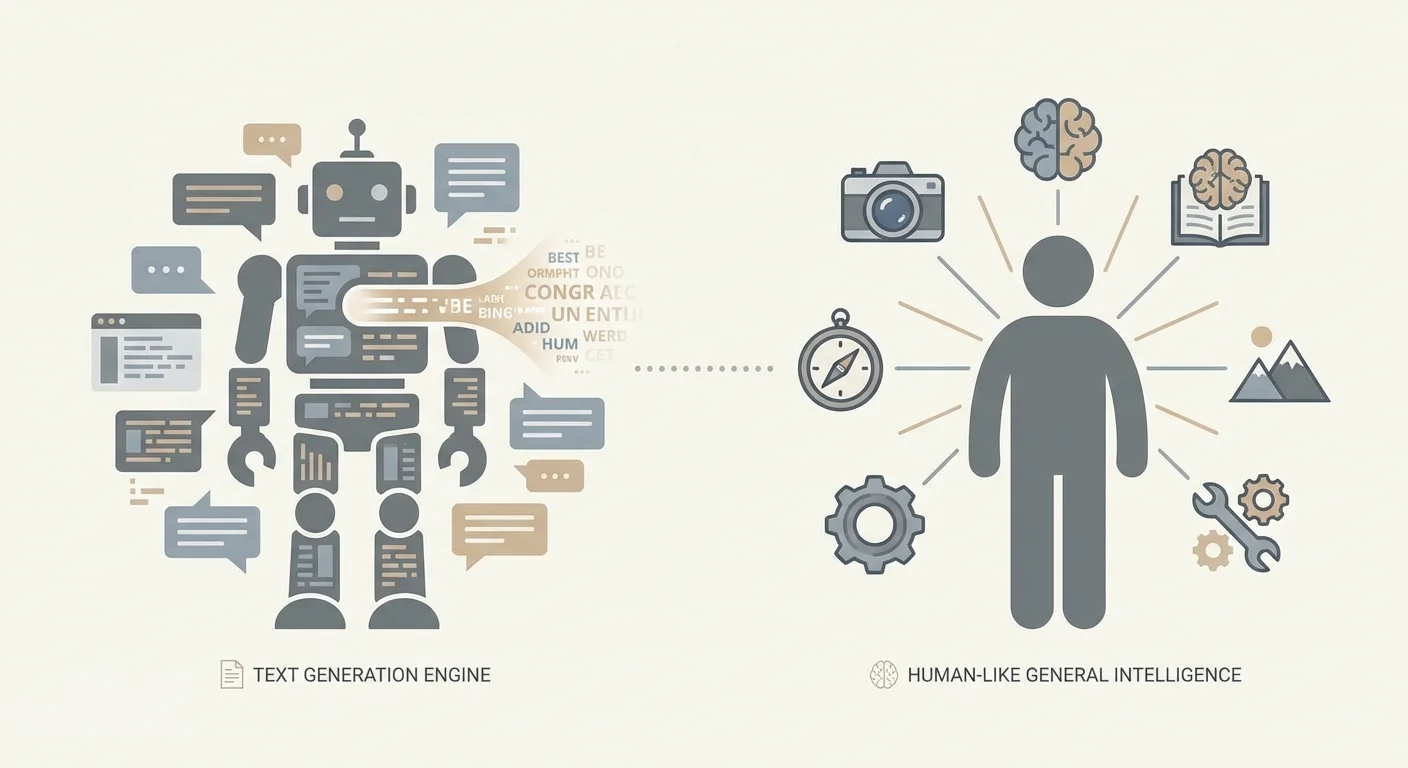

LLM vs. AGI: что мы вкладываем в эти термины

Большая часть спора «LLM являются (или не являются) AGI» — это на самом деле проблема терминологии. Люди используют одни и те же слова в разном смысле и начинают говорить мимо друг друга. Прежде чем обсуждать, на что способны современные системы, полезно зафиксировать определения.

LLM (Large Language Model) — это модель, обученная предсказывать и генерировать текст (иногда и другие модальности) по паттернам в больших наборах данных. Она может быть удивительно способной объяснять, суммировать, переводить, кодировать и общаться — потому что эти задачи хорошо согласуются с задачей предсказания языка. Однако сама по себе эта способность не гарантирует устойчивого понимания мира, долговременных целей или умения действовать автономно.

Узкий ИИ (Narrow AI) описывает системы, которые хорошо работают в конкретных доменах или областях задач — спам-фильтры, классификаторы медицинских изображений, оптимизация маршрутов и (возможно) большинство текущих развёртываний LLM. Узкие системы могут быть чрезвычайно мощными и экономически важными, не будучи «общими».

AGI (Artificial General Intelligence) — более расплывчатый термин, но практическая идея такова: агент, который может учиться и действовать в широком диапазоне задач и сред на уровне человека (или выше), с надёжными рассуждениями, способностью осваивать новые навыки и компетенцией действовать во времени без постоянной человеческой опоры.

Даже «обобщение» может означать разное. Иногда это означает успешную работу при новой формулировке знакомой задачи; иногда — перенос навыков между доменами; иногда — адаптацию к принципиально новым ситуациям с минимальным руководством. Это не одно и то же. LLM могут превосходно справляться с первым и при этом испытывать трудности с последним.

Этот спор важен, потому что на его основе принимаются реальные решения. Бизнесы могут излишне автоматизировать критические рабочие процессы, регуляторы — неверно нацеливать политики, команды — недооценивать потребность в мерах безопасности. В средах с высокими ставками — например, разработка ПО и медицинские рабочие процессы (включая контексты EMR/EHR) — уверенный вывод LLM может выглядеть как компетентность, пока не возникнет частный случай, где корректность и отслеживаемость бескомпромиссны.

Эта статья не утверждает, что LLM бесполезны или «всего лишь автозаполнение». Она утверждает, что красноречие не равно общему интеллекту, и что у современных LLM есть структурные ограничения, которые держат их в стороне от AGI.

Наконец, «никогда» — сильное утверждение. Рассматривайте это здесь не как пророчество, а как вопрос: что должно измениться — архитектурно и на системном уровне — чтобы подход на базе LLM можно было всерьёз считать AGI?

Как работают LLM (без истерии)

Большие языковые модели в основе своей — чрезвычайно способные предикторы текста. Они обучаются на огромных корпусах текста и усваивают статистические закономерности: какие последовательности слов обычно следуют друг за другом, как выражаются идеи и какие стили соответствуют каким контекстам. Когда вы даёте подсказку LLM, он не «ищет» сохранённый ответ и не обращается к мировому моделированию в том виде, как многие себе представляют. Он генерирует следующий токен—тот кусочек текста, который наиболее правдоподобен, учитывая предыдущие токены, и повторяет этот шаг.

Обучение: усвоение паттернов, а не гарантий фактов

Во время обучения модель видит последовательность токенов и должен предсказать следующий. На множестве примеров она настраивает внутренние параметры так, чтобы прогнозы улучшались. Это даёт впечатляющую способность продолжать текст так, чтобы он звучал связно — потому что связность сильно коррелирует с паттернами в обучающих данных.

Увеличение объёма данных и вычислений часто повышает филингвистичность и универсальность по простой причине: модель может представлять больше паттернов и точнее подгонять их. При достаточной ёмкости она обрабатывает редкие конструкции, учитывает более длинный контекст и имитирует специализированные стили письма. Ничто из этого не гарантирует устойчивого, укоренённого понимания сказанного; это показывает, что модель очень хороша в дополнении паттернов.

«Эмерджентные» способности: удивляют, но не волшебны

Некоторые способности кажутся появляющимися «внезапно» при увеличении размера модели — пошаговые объяснения, базовая помощь с кодом или более последовательное следование инструкциям. Часто происходит нечто менее таинственное: модель комбинирует знакомые паттерны новыми способами, переносит навык, встречающийся в смежных формах, или становится достаточно надёжной, чтобы пользователи это заметили.

Эти скачки могут казаться драматичными, но остаются согласующимися с предсказанием следующего токена как базовой целью.

Почему разговорный формат вводит в заблуждение

Интерфейсы-чаты поощряют человеческую интерпретацию: уверенный тон звучит как знание; вежливый тон — как намерение; стройное объяснение — как рассуждение. Но разговорный навык не равен пониманию, целям или отслеживанию истины. В практических развёртываниях самым безопасным подходом является относиться к выводу LLM как к сильному черновику — а не к авторитету.

Текст — не то же самое, что мир: пробел привязки

Языковая модель может выдавать убедительные описания реальности, не будучи «в» реальности. Текст — это запись человеческого опыта — сводки, истории, инструкции, аргументы — а не сам опыт. Когда LLM предсказывает следующий слово, он может звучать так, будто «понимает», но он может просто собирать паттерны, коррелирующие с пониманием, а не причинно-перцептивное освоение, которым люди пользуются для навигации в мире.

Что такое «привязка"

Привязка — это связь между символами (словами, числами, метками) и чем-то вне этих символов: восприятием, действием и обратной связью. Люди узнают, что «горячо», прикоснувшись к тёплой кружке, вздрогнув и запомнив. Мы уточняем «тяжело», поднимая, ошибаясь, меняя хват и пытаясь снова. Этот цикл — ощущение, действие, наблюдение последствий — якорит понятия в реальности.

Чисто текстовая модель лишена этого цикла. Она может повторить «стекло разбивается при падении», но не «владеть» ожиданием в том смысле, что оно обновляется при изменении условий (толстое стекло, резиновый пол, малая высота). Обычно у неё нет прямого канала, чтобы проверить, что истинно прямо сейчас, в этой ситуации, при этих ограничениях.

Где «знание слов о вещах" даёт сбой

Языковые паттерны становятся плохой заменой для привязанного взаимодействия в нескольких типичных ситуациях. Физическая причинность часто требует взвешивания множества взаимодействующих факторов, а не сопоставления одного ключевого слова. Пространственное рассуждение может проваливаться, когда инструкции зависят от поворотов, постоянных 3D-отношений или отображения слов на конкретную среду. Контексты в реальном времени — состояние запасов, показания сенсоров, статус пациента — особенно рискованны, потому что «типичный» ответ вчера может быть опасен сегодня. И по-настоящему новые ситуации обнажают основное ограничение: угадывание того, что звучит правильно, не равно тому, чтобы быть правым.

Почему этот пробел центральен для AGI

AGI подразумевает гибкую компетентность в разных средах, а не только красноречивый комментарий о них. Без привязки LLM может быть мощным помощником, но останется уязвимым к уверенной ошибке, когда мир требует проверки, эксперимента или калиброванной неопределённости.

Именно поэтому многие практические системы совмещают LLM с инструментами: базами данных, сенсорами, симуляторами и человеческими проверками. В прикладной работе — особенно в здравоохранении или системах, где важна безопасность — привязка не философская категория; это разница между полезным черновиком и выводом, на который можно безопасно полагаться.

Надёжность: галлюцинации, хрупкость и правда

LLM могут звучать уверенно, даже когда они ошибаются. Эти сбои часто называют галлюцинациями: вывода, которые беглы, подробны и уверенно сформулированы — но не основаны на проверенных фактах. Самая сложная часть — тон часто неотличим от правильного ответа, поэтому случайная «оценка взглядом» — слабая стратегия надёжности.

Почему беглый текст может уходить от правды

LLM обучены предсказывать наиболее вероятный следующий токен в контексте. Эта цель вознаграждает правдоподобие — то, что обычно следует в похожем тексте — больше, чем поиск истины. Если у модели нет нужной информации, она всё равно может сгенерировать лучшее предположение, соответствующее паттерну ответа. И даже когда правильная информация где-то есть в обучающем корпусе, модель не извлекает её как базу данных: она семплирует из выученного распределения вероятностей. В результате корректность и базовая цель обучения могут конфликтовать.

Хрупкость при небольших изменениях

Надёжность также ломается более тихими способами. Небольшие правки подсказки — слова, порядок, дополнительные ограничения — могут привести к существенно разным выводам. Скрытые ограничения, такие как длинная история чата или неоднозначные требования, могут незаметно направлять результат. Эта ломкость говорит о том, что вы взаимодействуете не со стабильным «движком рассуждений», а с чувствительным генератором, зависящим от контекста.

Поддержка принятия решений против принятия решений

Из-за галлюцинаций и хрупкости подсказок LLM лучше использовать как средство поддержки принятия решений: составление черновиков, суммаризация, мозговой штурм, перевод доменной речи и выдвижение вариантов. В тот момент, когда вы позволяете им принимать решения — утверждать изменение рабочего процесса в медицине, подписывать декларацию соответствия или финализировать финансовую логику — вы наследуете режим ошибок, который может быть тонким и убедительным.

В продакшне команды снижают этот риск, привязывая ответы к доверенным источникам или структурированным данным, требуя в рабочем процессе ссылок на доказательства (а не только уверенных утверждений), оборачивая критические шаги в детерминированные валидации (схемы, правила, unit-тесты) и сохраняя проверку человеком для действий с большим воздействием.

Надёжность — это не про то, чтобы делать модель «более умной на слух». Это про проектирование систем, где красивый внешний вид ответа никогда не бывает достаточным.

Рассуждение не гарантируется беглостью

Устойчивая заблуждение: если модель может звучать так, будто рассуждает, значит, она и правда рассуждает. LLM генерируют следующий токен, который лучше всего соответствует паттернам обучения и текущему контексту. Этот процесс может имитировать пошаговую логику — иногда впечатляюще — без надёжного выполнения требований реального рассуждения: согласованности, полноты и проверки ошибок.

Где «рассуждение» LLM кажется реальным

LLM часто хорошо отвечают, когда правильные ответы сильно коррелируют со знакомыми языковыми паттернами: составление объяснений, суммаризация компромиссов, предложение правдоподобных решений или создание кода, похожего на распространённые реализации. Даже если модель ничего не доказывает, она может быть эффективным эвристическим генератором: предлагает подходы, которые человек может проверить.

Где беглость даёт сбой

Проблемы проявляются, когда задача требует строгой, долговременной корректности, а не правдоподобного повествования. Многошаговая логика может разрушиться, если ранняя ошибка «заразит» все последующие шаги. Задачи, похожие на доказательства, требуют безупречных ограничений, а не убедительной прозы. Редкие крайние случаи и редкие условия могут быть недостаточно представлены в обучающем тексте. Конфликты между инструкциями, предположениями и скрытыми зависимостями могут тянуть завершение в неконсистентном направлении. И ответы «по форме решения» могут пропускать проверку именно потому, что они хорошо читаются.

Почему инструменты и уровни верификации важны

Картинка меняется, когда LLM — это компонент внутри системы, которая может самопроверяться. Внешние инструменты (калькуляторы, интерпретаторы, формальные решатели), извлечение авторитетных данных и структурированная верификация (unit-тесты, проверки согласованности, критика между моделями, проверка человеком) могут превратить беглые предложения в надёжные результаты.

Это не делает базовую модель AGI. Это делает её мощным интерфейсом для генерации кандидатов — тогда как остальная часть системы выполняет работу по привязке и корректности.

Агентность и цели: отсутствующие ингредиенты

Когда люди представляют AGI, они обычно думают о чём-то с агентностью: способном формировать цели, придерживаться их во времени, планировать действия для их достижения, наблюдать результаты и корректироваться на основе обратной связи. Агентность — это не просто «выполнение задач». Это устойчивое, самонаправленное поведение в меняющихся условиях.

Большинство LLM по умолчанию этого не имеют. Чат-модель генерирует следующий токен, учитывая подсказку. Она может говорить о целях, планах и намерениях с впечатляющей беглостью, но у неё нет внутреннего желания чего-либо, и она не продолжает добиваться цели, когда разговор заканчивается. Без внешней петли у неё нет стабильной цели, непрерывной обратной связи из мира и механизма решения, что делать дальше, кроме как отвечать.

Chat completion vs агентные системы

Настройка чат-комплешена реактивна: вы спрашиваете, он отвечает. Агентная архитектура оборачивает модель каркасом, обеспечивающим постоянство и контроль — очереди задач, инструменты (API), хранилища памяти, планировщики и оценщики, которые проверяют результаты. В такой конфигурации система демонстрирует поведение, похожее на агентность; языковая модель — лишь один компонент.

Это различие важно на практике. Если «AI-ассистент» может планировать задачи, изменять записи или запускать деплои, самая рискованная часть — не навык письма модели, а разрешения и цикл принятия решений вокруг неё.

Почему добавление агентности повышает риски

Предоставление модели доступа к инструментам и автономии может усилить обычные режимы ошибок. Она может преследовать неправильную цель, слишком широко трактовать неоднозначные инструкции или действовать на основе неверных предположений. Исправление — не только «умная модель»; нужны меры предосторожности: чёткие спецификации целей, ограниченный доступ к инструментам, подтверждения для критических действий, мониторинг и строгая оценка по реальным результатам.

Память, идентичность и непрерывность во времени

LLM могут звучать согласованно в пределах одного разговора, но эта «непрерывность» часто — иллюзия, созданная коротким окном контекста. В границах этого окна модель может ссылаться на только что сказанное и поддерживать согласованный тон. За его пределами — через сессии, дни или реальные задачи — у неё нет врождённого долговременного «я», устойчивых убеждений или длительного понимания ваших целей.

Короткий контекст — не долгосрочная память

То, что люди называют «памятью» в LLM, обычно просто текст, который ещё видим в подсказке. Это ближе к рабочей памяти, чем к жизненному архиву. Как только более ранние детали выпадают из окна контекста, модель их не помнит; она угадывает, что было бы правдоподобно.

Общий интеллект, в представлениях большинства людей, зависит от непрерывности: учиться на ошибках, аккумулировать надёжные факты, пересматривать убеждения и оставаться согласованным с долгосрочными целями, даже когда беседа обнуляется.

Дрейф идентичности и предпочтений

Без постоянного состояния LLM могут противоречить сами себе между сессиями: инструмент, который «предпочитал» один подход сегодня, завтра может рекомендовать противоположный — не потому, что он изменил мировоззрение, а потому что сэмплируется другое завершение. Даже в рамках одной сессии небольшие изменения подсказки могут дать смещение приоритетов или новую интерпретацию того, что имел в виду пользователь.

Эта хрупкость важна для реальных задач — сбор требований, медицинская документация, многонедельные проекты разработки — где согласованность и отслеживаемость так же важны, как и красноречие.

Добавление памяти через извлечение и структурированное состояние (и что это не решает)

Чтобы компенсировать, команды прицепляют внешнюю память: системы извлечения, базы данных, профили пользователей и структурированное состояние, которое вновь подмешивается в подсказку. Это может существенно улучшить непрерывность и широко применяется в продакшне.

Типичные слои включают резюме разговоров, извлечение из документов и баз знаний, профили предпочтений пользователей и права, хранимые в базе данных, а также структурированное состояние задач (принятые решения, открытые вопросы, ограничения). Но это — леса вокруг модели, а не внутреннее, самоподдерживающееся «я». Извлечение может выдать неверный факт, резюме может стереть нюанс, и модель всё ещё может неправильно интерпретировать сохранённое состояние.

На практике надёжное долговременное поведение обычно требует тщательного проектирования системы плюс проверки человеком.

Обобщение вне распределения обучения

AGI — если он когда-либо появится — должен уметь не только хорошо работать на знакомых паттернах. Он должен переносить знание в принципиально новые домены, правила и цели, особенно когда «правильного ответа" нельзя получить простым ремиксом прошлых примеров.

Обобщение vs «выглядит достаточно похоже"

Много успеха LLM лучше описывать как мощную интерполяцию: генерацию выходов, согласующихся со статистической структурой данных, которые они впитали. Когда задача похожа на распространённые форматы из обучения — объяснения, суммаризации, шаблоны кода, скрипты поддержки клиентов — LLM могут казаться широко способными.

Но интерполяция не то же самое, что обобщение в смысле AGI. Модель может отлично дополнять паттерны и всё же провалиться, когда задача требует выучить новое правило на лету, построить стабильную внутреннюю модель незнакомой среды или обновить убеждения, когда наблюдения противоречат первоначальной гипотезе.

Отказы вне распределения — не крайние случаи

Реальная работа постоянно создаёт ситуации вне распределения: новые регуляции, новые продуктовые ограничения, неожидаемое поведение пользователей, интерфейсы инструментов, которые меняются, наборы данных с новыми схемами. LLM часто резко деградируют, когда сменяется внешняя форма или когда успех зависит от скрытых ограничений, а не от текстовой правдоподобности.

Проблемы проявляются, когда новые правила противоречат общим конвенциям, когда действия важнее формулировок (многошаговое использование инструментов при ограничениях), когда появляются редкие сочетания понятий или когда инструкции неоднозначны — условия, где «звучать правдоподобно» легко, а быть правым сложно.

Почему бенчмарки могут приукрашивать возможности

Бенчмарки полезны, но часто оптимизированы под сравнимость, а не под сюрприз. Как только бенчмарк становится популярным, он формирует обучение, стратегии подсказок и нормы оценки. Очки растут, тогда как реальный вопрос — «Справится ли система с тем, чего мы не догадались протестировать?» — остаётся открытым.

Для бизнеса этот разрыв — операционный: система может выглядеть «как AGI» на внутренних демонстрациях и провалиться, когда рабочий процесс клиента отклоняется от тестового набора. Продакшн-системам обычно нужны ограниченные интерфейсы, шаги верификации и эскалация к человеку для по-настоящему новых случаев.

Согласование и безопасность: возможностей недостаточно

Когда люди говорят, что очень способная модель — «по сути AGI», они обычно фокусируются на том, что она делает в демо. Согласование ставит другой вопрос: надёжно ли система преследует намерение пользователя в рамках человеческих ограничений, даже когда подсказка неоднозначна, враждебна или морально нагружена?

На практике согласование означает попадание в цели (чего хочет пользователь), ценности (что допускает общество) и границы (конфиденциальность, законность, политики безопасности, операционные правила) в грязных ситуациях.

Почему RLHF помогает — и почему этого мало

Тюнинг инструкций и RLHF (обучение с человеческой обратной связью) делают модель более кооперативной и менее токсичной. Но они не превращают модель в последовательно принципиального рассуждателя. Система по-прежнему учит паттернам предпочитаемых ответов, а не осваивает человеческие ценности.

Согласование также не одна цель. Нужно балансировать идеалы, которые могут конфликтовать: полезность, честность, безопасность, приватность и справедливость. Оптимизация одного часто давит на другие. Модель, обученная быть максимально «полезной», может слишком много отвечать и домысливать; модель, натренированная на жёсткую безопасность, может отказывать в безобидных запросах; чрезмерно осторожная модель будет раздражать пользователей и толкать их к небезопасным обходным путям.

Почему заявления об AGI должны включать управление

Если «AGI» означает систему, которая может действовать широко и компетентно, безопасность не может быть последним пунктом — большая способность увеличивает зону поражения ошибок. Реальные развёртывания нуждаются в управлении: чёткие политики допустимого использования, логирование и возможность аудита, контроль доступа, проверка человеком для чувствительных рабочих процессов и реагирование на инциденты при неожиданном поведении системы.

В продуктах с высокими ставками согласование — это не лозунги, а инженерная дисциплина: ограждения, оценки, мониторинг и отчётность. Возможности привлекают внимание; безопасность заслуживает доверие.

Могут ли системы на базе LLM стать AGI? Что должно измениться

Ключевой вопрос не в том, можно ли «апгрейдить» LLM до AGI, просто добавив инструменты. Вопрос в том, закроют ли добавление восприятия, памяти и действия фундаментальные пробелы: надёжное рассуждение, привязанное понимание и когерентное поведение на длинных горизонтах.

Инструменты помогают — но не создают понимание по щелчку

Гибридные системы уже выглядят значительно способнее, чем модель только для чата. LLM, который может искать, извлекать документы, запускать код, вызывать API и проверять свою работу, будет казаться «умнее» во многих задачах. На практике такой подход снижает ошибки: извлечение якорит ответы в авторитетных источниках, исполнение проверяет математику и логику.

Но использование инструментов в основном меняет производительность, а не природу базового познавательного механизма. LLM остаётся вероятностным генератором текста; окружающая система должна его ограничивать, валидировать и решать, когда ему доверять.

Что действительно приблизит системы к AGI

Если избегать ярлыков и говорить об архитектурах, несколько изменений важнее, чем просто рост размеров модели:

- Привязанные мировые модели: обучение, связанное с восприятием и взаимодействием, а не только с текстом.

- Проверяемые конвейеры рассуждения: систематические проверки (исполнение, формальные методы, доказательства, тесты согласованности) по умолчанию, а не по желанию.

- Долговременная память с управлением: прочные, редактируемые знания и контекст пользователя без неконтролируемого дрейфа и рисков приватности.

- Планирование и управляющие петли: явное декомпозирование целей, мониторинг и восстановление после ошибок на длинных горизонтах.

- Обучение на правде и калибровке: системы, которые умеют воздерживаться и надёжно сигнализировать неопределённость.

Почему лучше говорить о способностях, а не о «AGI»

«AGI» сжимает в одном слове множество свойств — надёжность, автономию, переносимость, робастность, безопасность — и маскирует нюансы. Описывать системы через то, что они умеют делать, в каких условиях и с какими режимами сбоев — честнее и полезнее с точки зрения инженерии и управления рисками. Это также помогает избежать ловушки, когда впечатляющие демо принимают за общий, надёжный интеллект.

Практические выводы для бизнеса, строящего решения с LLM

LLM могут приносить реальную пользу уже сегодня — если вы рассматриваете их как вероятностных ассистентов, а не как автономные «понимающие» движки. Надёжные развёртывания начинают с чёткого объёма: какие решения модель может влиять, что она никогда не должна решать и какие доказательства она должна предоставлять при выдаче ответа.

Используйте LLM в поддерживающих ролях с ограждениями: защищайте входы (фильтры приватности, шаблоны подсказок, ограниченный доступ к инструментам) и ограничивайте выходы (проверки формата, привязка к внутренним источникам, явное указание неопределённости). Для рабочих процессов с высоким воздействием — здравоохранение, финансы, юриспруденция — требуйте проверки человеком и облегчайте работу рецензента, показывая рядом с черновиком модели релевантный контекст источников.

Аудит — простая, но часто упускаемая практика: регулярно выборочно проверяйте выводы, помечайте ошибки (галлюцинация, упущение, небезопасное предложение, нарушение политики) и используйте эти метки для обновления подсказок, настройки извлечения, правил маршрутизации и тестов.

Краткое правило:

- Используйте LLM для черновиков, суммаризаций, извлечения и вопросов/ответов по контролируемым внутренним знаниям.

- Не полагайтесь на них как на источник истины и не используйте для необратимых утверждений и открытой автоматизации без ограничений.

Если вы превращаете эти идеи в промышленное ПО — особенно в регламентируемых доменах — команды вроде SaaS Production (saasproduction.com) обычно фокусируются на дизайне систем, а не на хайпе: интеграция ИИ в связке с проверкой человеком, структурированными проверками и трассируемостью, чтобы прирост скорости не шёл вразрез с надёжностью.

Часто задаваемые вопросы

Что такое LLM на практике?

LLM (Large Language Model) — прежде всего вероятностный текстовый генератор, обученный предсказывать следующий токен по паттернам в больших наборах данных. Он может быть чрезвычайно полезен для задач, связанных с языком (черновики, суммаризации, перевод, помощь с кодом), но это не даёт автоматически: - привязанного к реальности понимания - надёжного отслеживания правды - устойчивых целей или самонаправленного поведения во времени

Что обычно имеют в виду под AGI?

AGI обычно понимают как широко способный интеллект, который может обучаться и действовать в самых разных средах на уровне человека (или выше) с надёжным рассуждением и способностью функционировать во времени без постоянной человеческой опоры. На практике это предполагает устойчивость, усвоение навыков, планирование и стабильную работу в принципиально новых ситуациях — а не просто красноречивые ответы.

Почему дебаты о «LLM vs AGI» так запутаны?

Потому что «обобщение» используется в разных смыслах. Модель может обобщать на новый способ формулировки знакомой задачи (часто сильная сторона LLM), но при этом не уметь: - переносить навыки в новые домены с другими правилами - адаптироваться на основе реальной обратной связи - сохранять корректность при крайних случаях и сдвиге распределения

Что такое «пробел привязки» и почему он важен?

Привязка — это связь между символами (словами) и реальным восприятием/действием/обратной связью. Человек усваивает понятия через взаимодействие (ощущение → действие → наблюдение → обновление). Текстовая модель может убедительно описывать мир, не имея прямого способа проверить, что истинно «сейчас» в конкретной среде — и это ключевой пробел для надёжной автономности.

Почему LLM галлюцинируют даже когда звучат уверенно?

Галлюцинации происходят потому, что модель оптимизирована на правдоподобное продолжение, а не на гарантированную истину. Если необходимая информация отсутствует в подсказке (или неоднозначна), модель всё равно может сгенерировать «ответную» форму, которая хорошо звучит. Оперативные меры обычно включают: - требование ссылок на утверждённые внутренние источники (в рамках рабочего процесса) - извлечение из доверенных хранилищ данных - детерминированную валидацию (схемы, правила, unit-тесты) - проверку человеком для выводов с высоким риском

Почему результаты LLM так чувствительны к формулировке подсказки?

Поведение LLM заметно меняется от небольших правок подсказки, другого порядка ограничений или скрытого контекста в длинном чате. Это признак того, что вы имеете дело с чувствительным к контексту генератором, а не со стабильным «механизмом рассуждения». Чтобы уменьшить хрупкость: - используйте шаблоны с последовательной структурой - формулируйте требования явно и проверяемо - добавляйте автоматические проверки (формат, инварианты) - тестируйте с фиксированным набором тестов перед развертыванием изменений

LLM действительно рассуждают, или просто имитируют рассуждение?

Не всегда. LLM могут подражать пошаговому рассуждению и часто предлагать хорошие варианты решений, но они могут пропускать валидацию, «дрейфовать» в середине цепочки или ломаться на редких ограничениях. Более безопасная схема: - разрешать модели генерировать варианты - проверять их инструментами (выполняемый код, калькуляторы, решатели) - обеспечивать корректность тестами и рецензированием - считать окончательное решение результатом контролируемой системы, а не произвольного завершения

В чём разница между чат-моделью и «агентом»?

По умолчанию большинство LLM реактивны: они отвечают на подсказки и не сохраняют цели или не действуют, если система вокруг них не даёт память, инструменты и управляющую петлю. Добавление агентности (API, права на запись, автоматические действия) увеличивает поверхность ошибок. Практические меры предосторожности включают принцип наименьших привилегий для инструментов, подтверждения перед необратимыми действиями, мониторинг и чёткие пути эскалации.

Почему у LLM нет настоящей долговременной памяти и постоянной идентичности?

То, что обычно называют «памятью», чаще всего — просто текст, который ещё виден в контексте подсказки. Как только он выходит за окно контекста, модель не помнит — она угадывает. Для обеспечения непрерывности команды обычно добавляют внешнее состояние: - структурированное состояние задач (решения, ограничения, открытые вопросы) - извлечение из проверенных документов - профили пользователей и права, хранящиеся вне модели Даже тогда нужны правила хранения (что можно сохранять, кто имеет доступ, как исправлять) и проверки на ошибочное извлечение или неверную интерпретацию.

Как бизнесам безопасно использовать LLM в продакшне (особенно в регламентируемых областях)?

Фокусируйтесь на возможностях и режимах отказа, а затем проектируйте систему вокруг них: - Используйте LLM для черновиков, суммаризаций, извлечения и вопросов/ответов по контролируемым внутренним знаниям. - Не делайте их источником истины для медицинских, юридических, финансовых или комплаенс-утверждений. - В здравоохранении и в рабочих процессах, смежных с EMR/EHR, требуйте трассируемости, логов аудита и проверки человеком. - Добавьте детерминированные предохранители (схемы, правила, unit/integration-тесты) и регулярный аудит выходных данных. Цель — скорость вместе с надёжностью: рассматривайте модель как компонент внутри верифицированного рабочего процесса, а не как автономный авторитет.